上一个

EVI 2相关AI工具集

-

VocapiaVocapia Research开发的语音识别软件提供先进的语音处理技术,支持多语种识别,并能应用于广播监控、讲座和研讨会转录、视频字幕、电话会议转录...

VocapiaVocapia Research开发的语音识别软件提供先进的语音处理技术,支持多语种识别,并能应用于广播监控、讲座和研讨会转录、视频字幕、电话会议转录... -

WavtoolWavTool是一款在浏览器中使用AI助手免费制作高质量音乐的产品。它提供了一系列强大的功能,包括音乐创作、音频编辑、混音和编曲等。用户可以通过简单的...

WavtoolWavTool是一款在浏览器中使用AI助手免费制作高质量音乐的产品。它提供了一系列强大的功能,包括音乐创作、音频编辑、混音和编曲等。用户可以通过简单的... -

Aimusic soAI Music Generator Free Online是一个创新的音乐生成平台,利用先进的深度学习技术,将用户输入的文本转化为充满情感和高质量的...

Aimusic soAI Music Generator Free Online是一个创新的音乐生成平台,利用先进的深度学习技术,将用户输入的文本转化为充满情感和高质量的... -

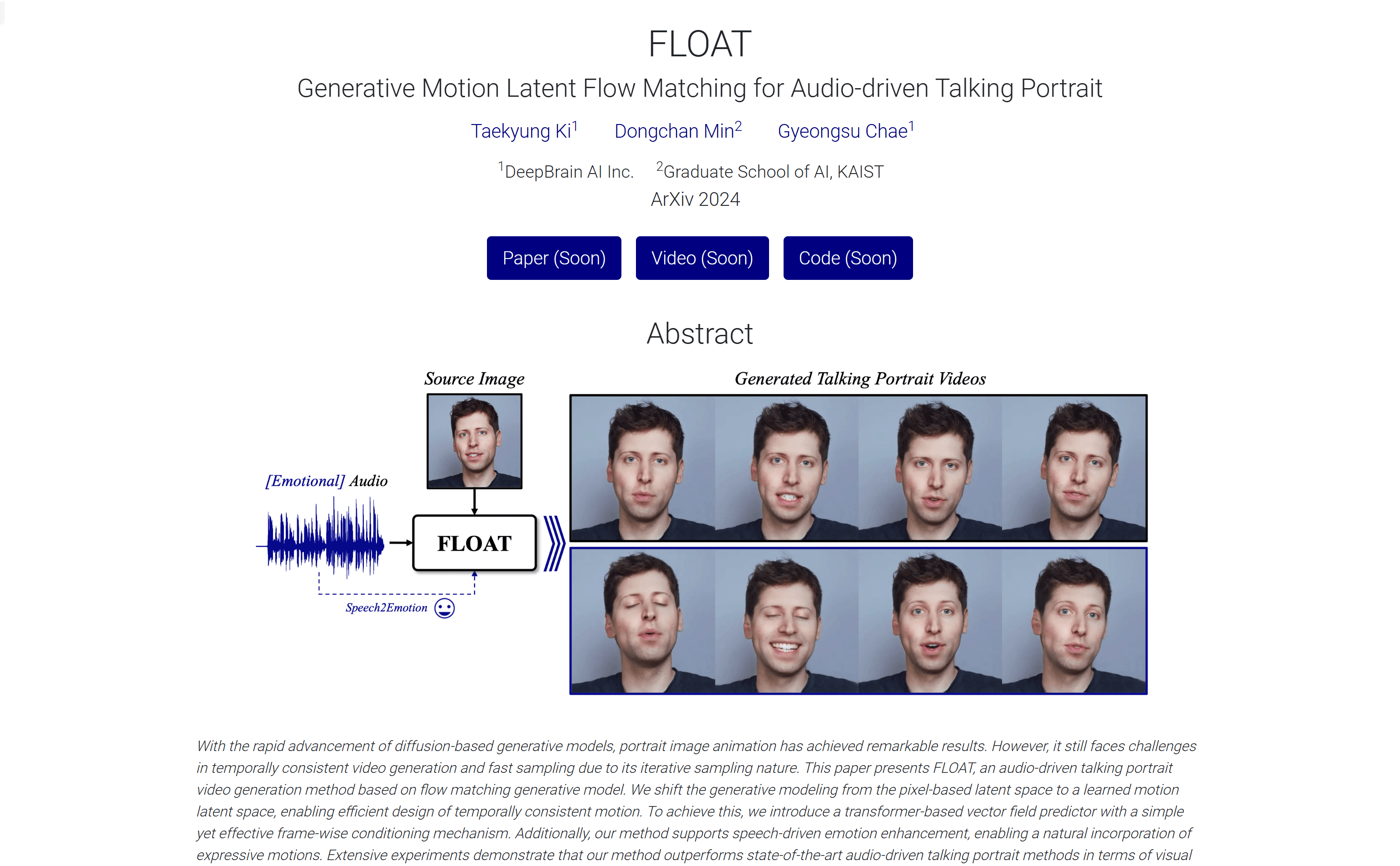

FLOATFLOAT是一种音频驱动的人像视频生成方法,它基于流匹配生成模型,将生成建模从基于像素的潜在空间转移到学习到的运动潜在空间,实现了时间上一致的运动设计...

FLOATFLOAT是一种音频驱动的人像视频生成方法,它基于流匹配生成模型,将生成建模从基于像素的潜在空间转移到学习到的运动潜在空间,实现了时间上一致的运动设计... -

讯飞星火讯飞星火是科大讯飞推出的一款全面对标GPT-4 Turbo的AI大语言模型,它通过集成多种AI技术,如语音识别、自然语言处理、机器学习等,为用户提供高...

讯飞星火讯飞星火是科大讯飞推出的一款全面对标GPT-4 Turbo的AI大语言模型,它通过集成多种AI技术,如语音识别、自然语言处理、机器学习等,为用户提供高... -

Cleanvoice AICleanvoice AI是一种人工智能,可以从您的播客或音频录音中去除填充声音(如“嗯”、“呃”)、嘴部声音(如唇舌音)和口吃声。它可以自动检测和删...

Cleanvoice AICleanvoice AI是一种人工智能,可以从您的播客或音频录音中去除填充声音(如“嗯”、“呃”)、嘴部声音(如唇舌音)和口吃声。它可以自动检测和删... -

OriglioOriglio是一款音频转文字的服务,还提供更多功能。它可以将您的音频消息转录成文字,帮助您管理和整理语音消息。您可以将音频转发给Origlio,几秒...

OriglioOriglio是一款音频转文字的服务,还提供更多功能。它可以将您的音频消息转录成文字,帮助您管理和整理语音消息。您可以将音频转发给Origlio,几秒... -

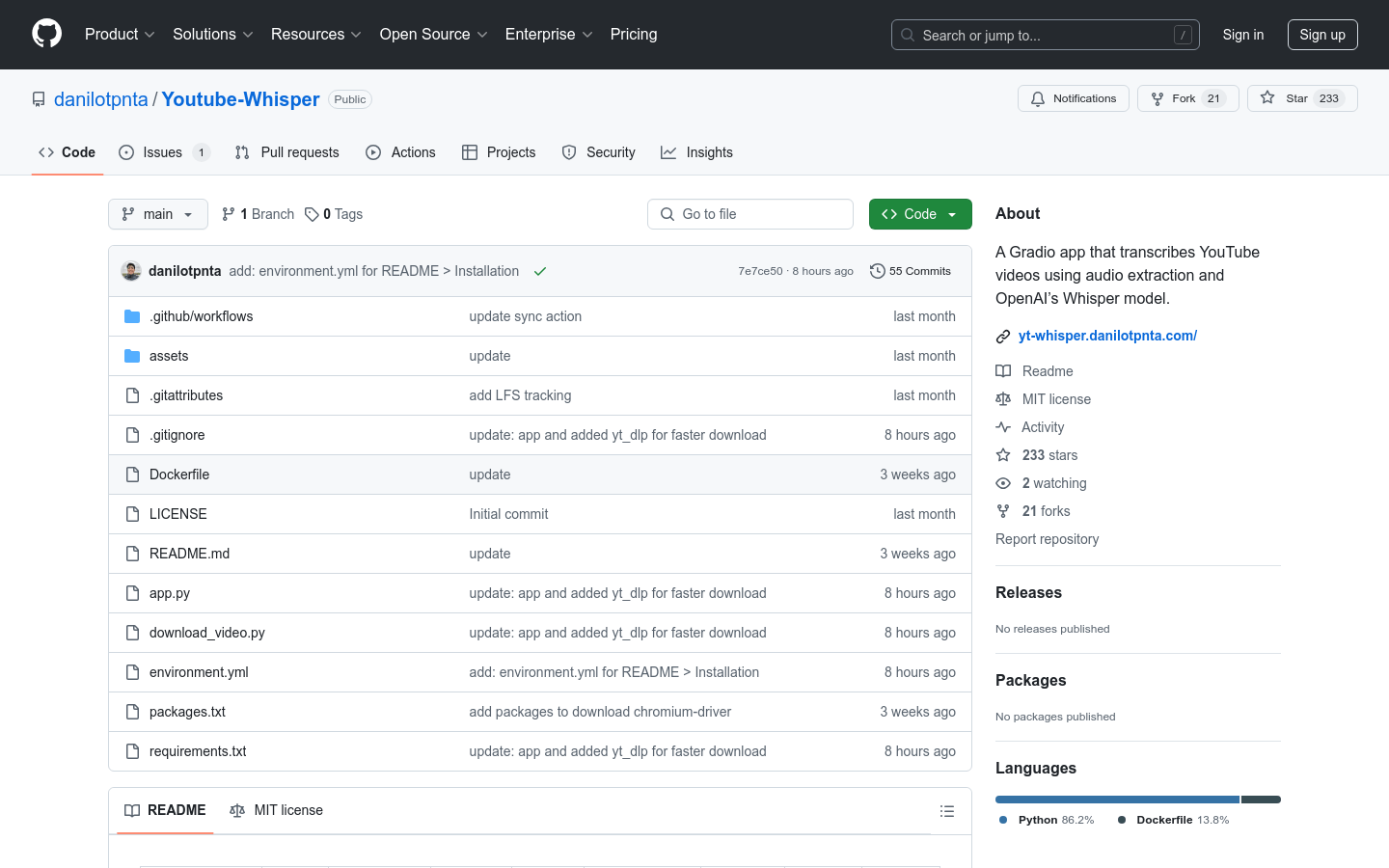

Youtube-WhisperYoutube-Whisper是一个基于Gradio的应用程序,它通过提取YouTube视频的音频并使用OpenAI的Whisper模型来转录成文本。...

Youtube-WhisperYoutube-Whisper是一个基于Gradio的应用程序,它通过提取YouTube视频的音频并使用OpenAI的Whisper模型来转录成文本。... -

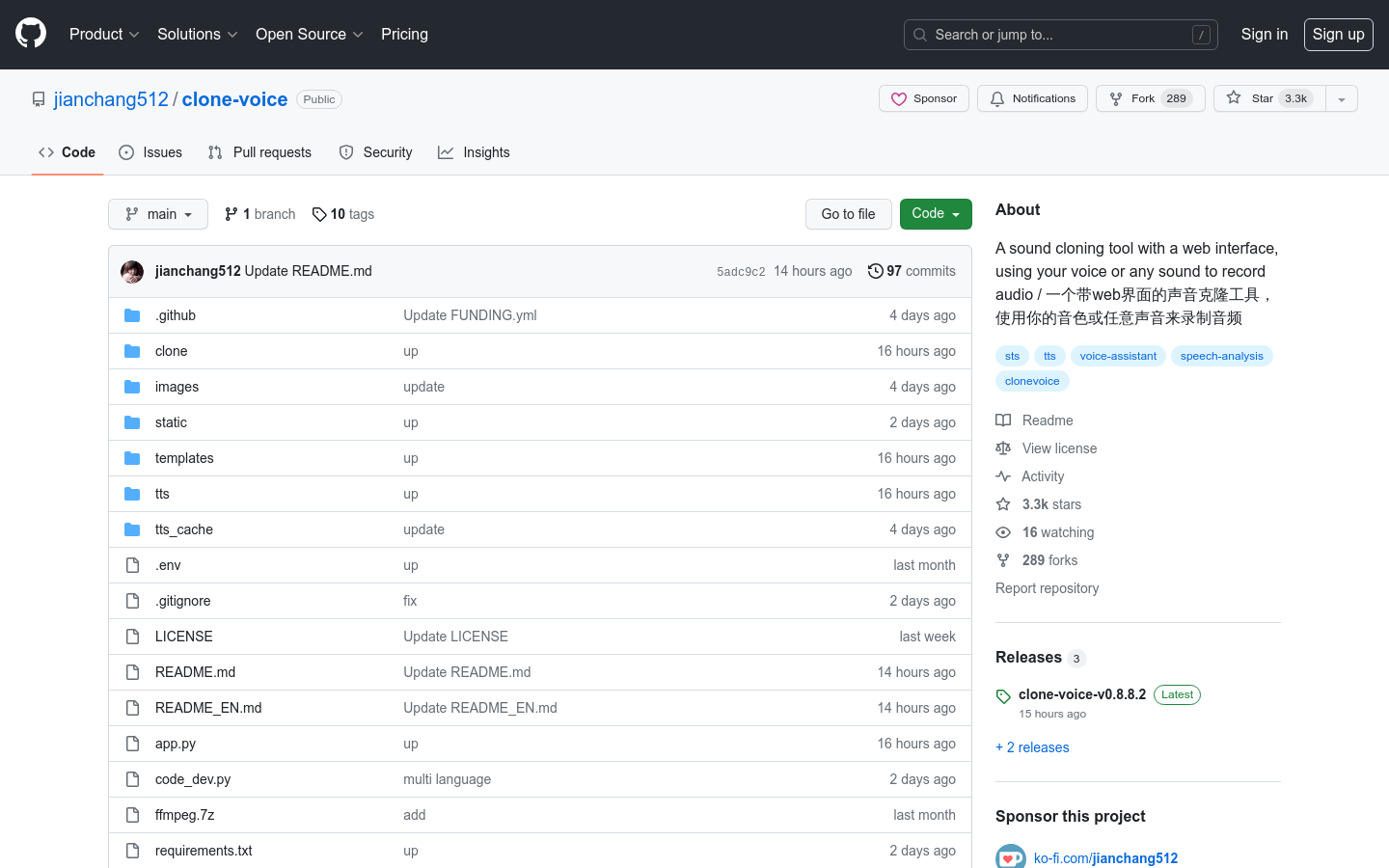

Clone-VoiceClone-Voice是一个带 web 界面的声音克隆工具,可使用任何人类音色,将一段文字合成为使用该音色说话的声音,或者将一个声音使用该音色转换为另...

Clone-VoiceClone-Voice是一个带 web 界面的声音克隆工具,可使用任何人类音色,将一段文字合成为使用该音色说话的声音,或者将一个声音使用该音色转换为另... -

NovaMSSNovaMSS是一款基于最顶级的AI模型调优后的新一代音乐源分离工具,可以一键提取伴奏、人声、贝斯、鼓点、分离音轨等。它的强大算法基于MSS领域最顶级...

NovaMSSNovaMSS是一款基于最顶级的AI模型调优后的新一代音乐源分离工具,可以一键提取伴奏、人声、贝斯、鼓点、分离音轨等。它的强大算法基于MSS领域最顶级... -

OuteTTS-0.1-350MOuteTTS-0.1-350M是一款基于纯语言模型的文本到语音合成技术,它不需要外部适配器或复杂架构,通过精心设计的提示和音频标记实现高质量的语音合...

OuteTTS-0.1-350MOuteTTS-0.1-350M是一款基于纯语言模型的文本到语音合成技术,它不需要外部适配器或复杂架构,通过精心设计的提示和音频标记实现高质量的语音合... -

Adobe Project Music GenAI ControlAdobe Research开发的Project Music GenAI Control是一个实验性的AI音乐生成和编辑工具,它允许创作者通过文本提示...

Adobe Project Music GenAI ControlAdobe Research开发的Project Music GenAI Control是一个实验性的AI音乐生成和编辑工具,它允许创作者通过文本提示...

卓商AI

AI爱好者的一站式人工智能AI工具箱,累计收录全球10,000⁺好用的AI工具软件和网站,方便您更便捷的探索前沿的AI技术。本站持续更新好的AI应用,力争做全球排名前三的AI网址导航网站,欢迎您成为我们的一员。

最新收录

Spoke

Spoke是一款AI插件,为产品经理提供强大的、注重隐私的AI功能,能够在几秒钟内为用户提供上下文信息。它可以帮助全球快速增长的团队节省时间,创造上下...

LastMile AI

LastMile AI是一个AI开发平台,专为工程师而设计,可以用于原型开发和生成式AI应用的生产。它提供了一站式的多模态AI模型访问,包括语言模型(...

Dokkio

Dokkio是一款利用人工智能技术提供云文件协作的工具。它能帮助用户管理多个活动、搜索文档和文件、整理研究材料、组织内容库,并将所有文件和内容集中在一...

Engage Sphere AI

Engage Sphere是一个基于AI的员工参与度分析平台。它可以深入分析公司各个部门、团队和岗位的参与度,帮助管理者明确团队互动症结所在,并采取行...

Pikzels

Pikzels连接顶级人才和有远见的客户。我们促进协作,释放创意卓越。加入我们,获取来自各个领域的优秀专业人才。体验协作的力量,释放你的创意潜能。Pi...

Zoho Cliq

Zoho Cliq是一款专为提高企业工作效率而设计的在线即时通讯和协作平台。它将团队成员、对话和工作流集中在一个地方,实现无缝连接。主要功能包括:组织...

猜你喜欢

looka

使用Looka的AI驱动平台为您的业务创建一个美丽的品牌。在几分钟之内获取专业设计的徽标,而无需设计经验或额外的软件。用您为之骄傲的令人惊叹的品牌留下...

Claude 3.5 Haiku

Claude 3.5 Haiku是Anthropic公司推出的最新最快的模型,它在编程、工具使用和推理任务上表现出色,并且价格亲民。该模型在速度上与C...

pitchbob io

PitchBob.io是由AI支持的数字助理,旨在帮助Wantrepreneurs成为企业家。它不仅有助于推销,还可以帮助完成日常任务,例如验证想法和...

Fryderyk

Fryderyk是一个集成了AI助手的音乐制作网页应用程序,它提供了一个浏览器内的音乐创作环境,支持即插即用,连接麦克风或任何MIDI乐器。用户可以访...

mymap.ai

MyMap.AI是一个将文本思路转化为脑图和演示文稿的AI工具。它通过简单的聊天界面,将您的文本思路转化为可视化的脑图和演示文稿。非常适合学生、教师和...

RunComfy

Runcomfy是一个基于云端的环境,可以在3秒内释放你的AI艺术创造力。每个工作流程都配备了所有必要的自定义节点和模型,确保开始无忧。点击网址了解更...

最新文章

1

2

3

4

5

6

7

8

9

10