相关AI工具集

-

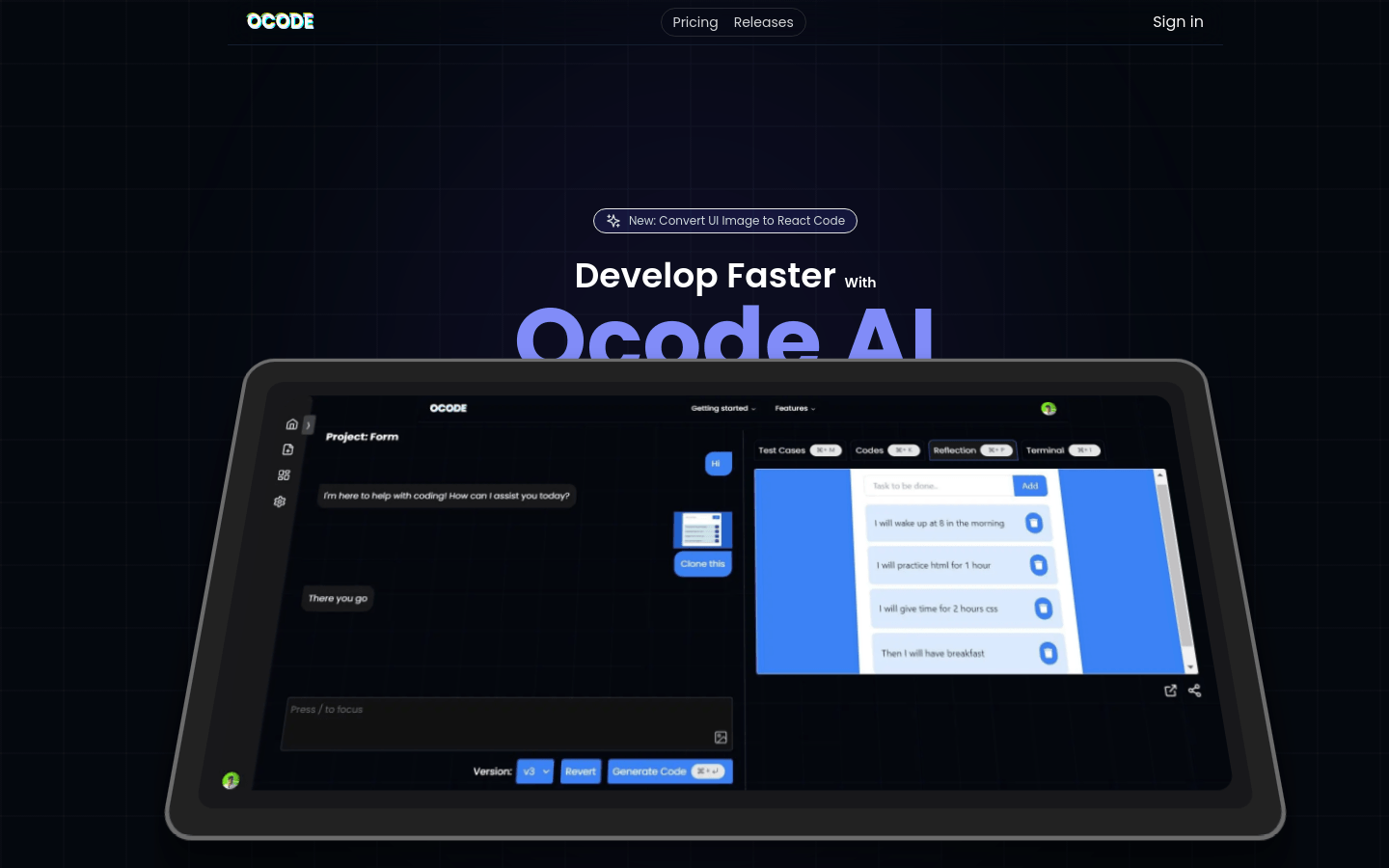

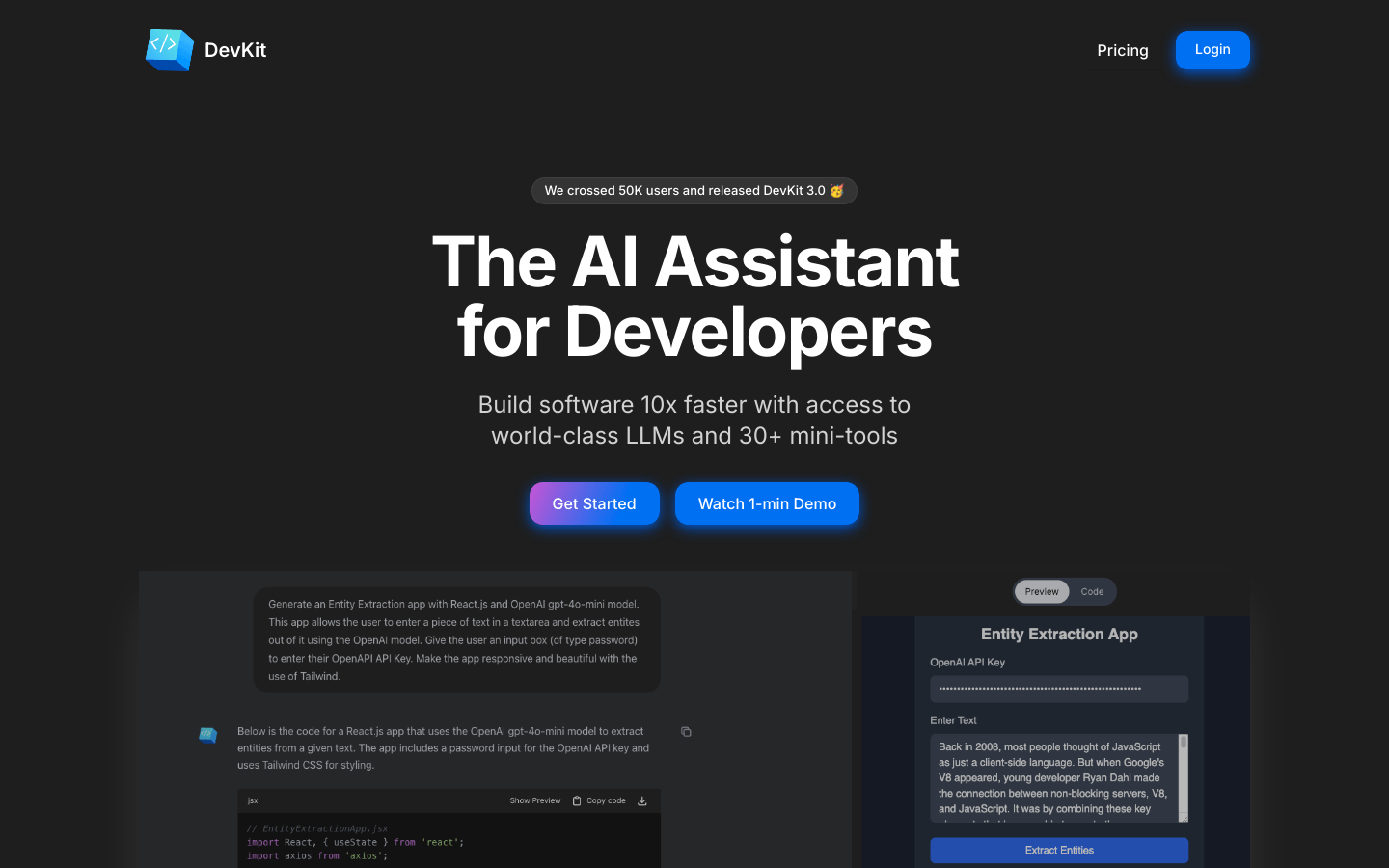

DevKitDevKit是一个专为开发者设计的AI助手,它结合了世界领先的大型语言模型(LLMs)和超过30个迷你工具,帮助开发者快速构建软件,显著提升开发效率。...

DevKitDevKit是一个专为开发者设计的AI助手,它结合了世界领先的大型语言模型(LLMs)和超过30个迷你工具,帮助开发者快速构建软件,显著提升开发效率。... -

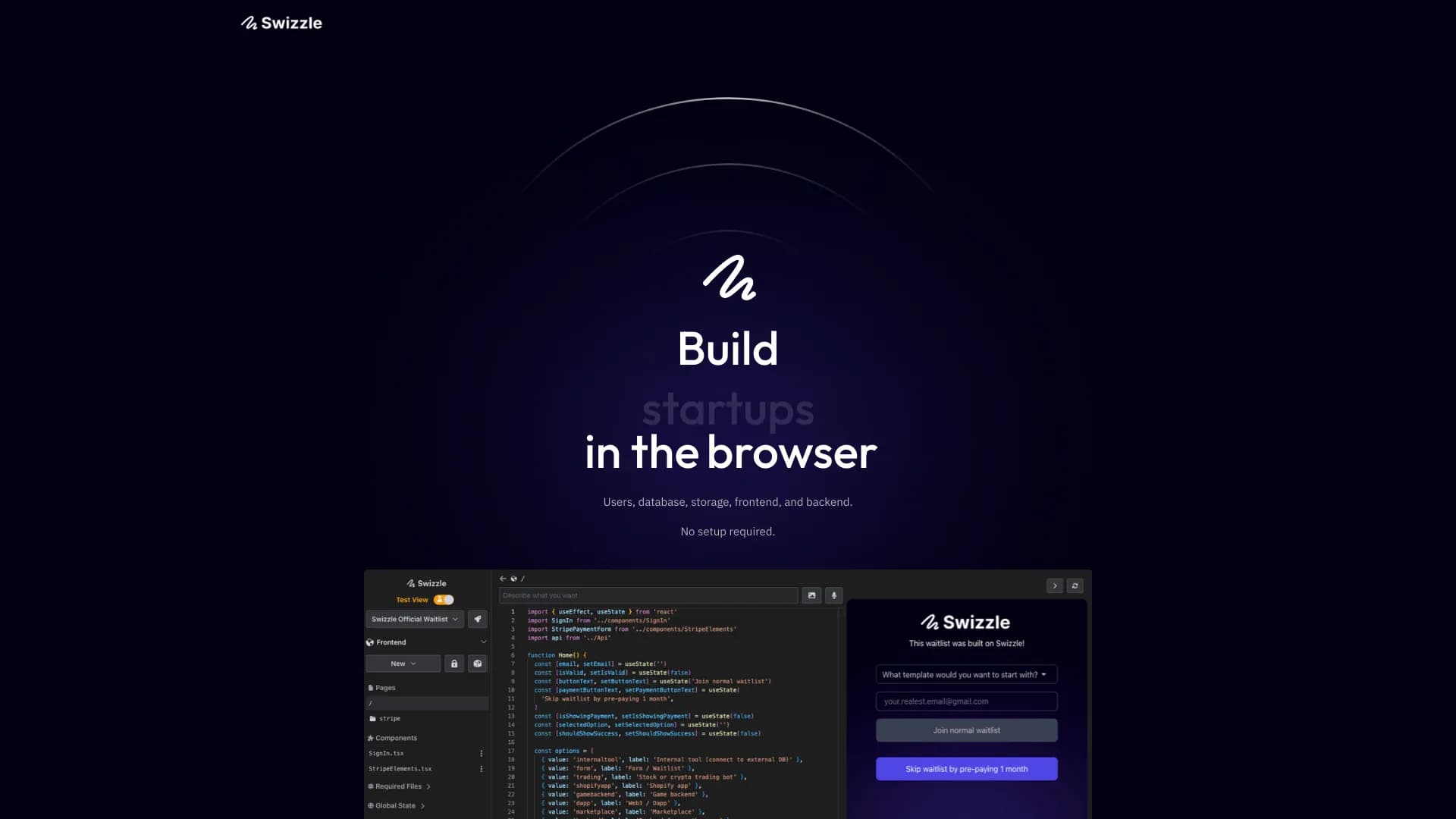

SwizzleSwizzle是一个全栈开发平台,提供数据库、认证、前端和后端等功能,可快速构建应用。它支持JavaScript语言,提供REST端点、定时任务、We...

SwizzleSwizzle是一个全栈开发平台,提供数据库、认证、前端和后端等功能,可快速构建应用。它支持JavaScript语言,提供REST端点、定时任务、We... -

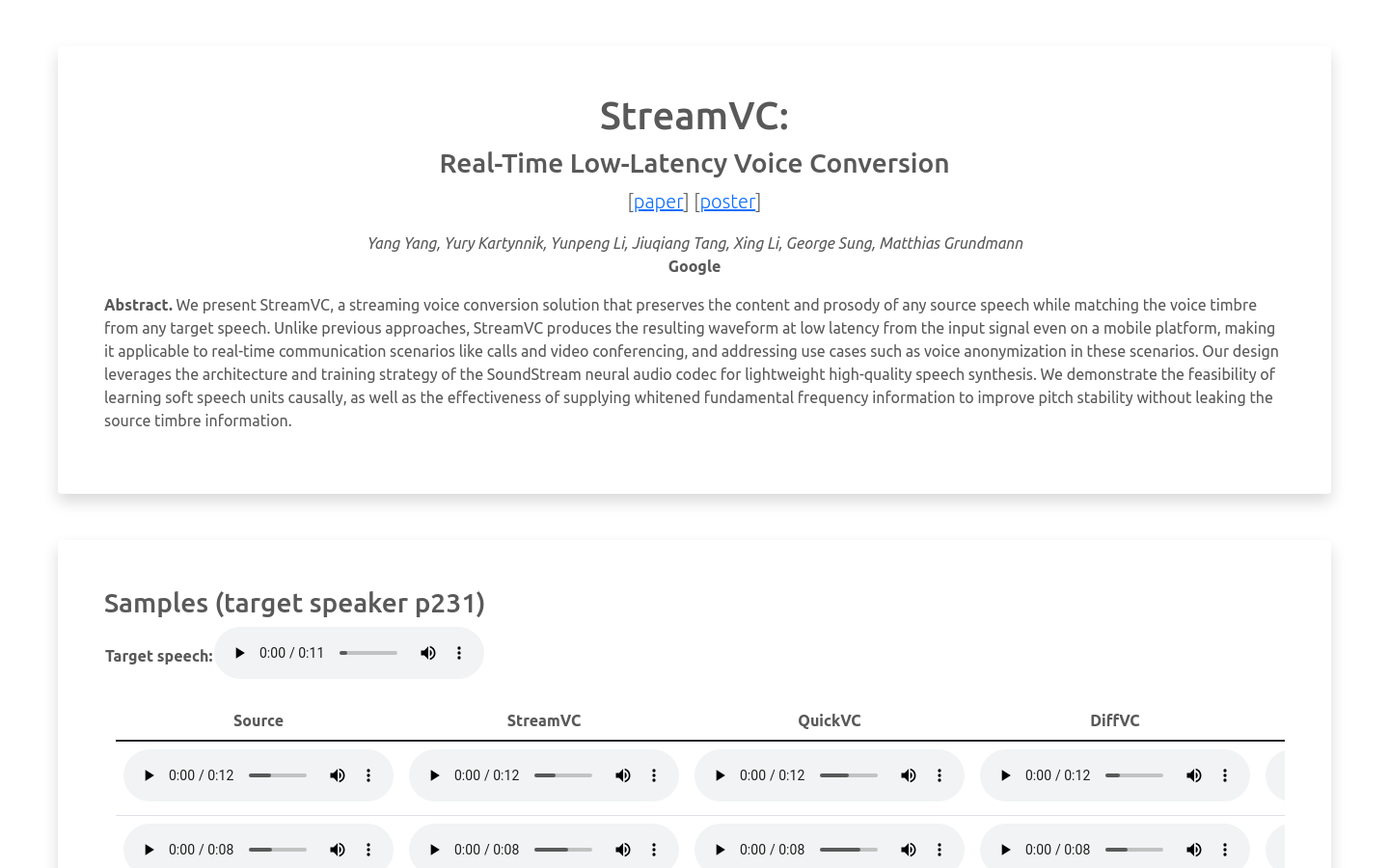

StreamVCStreamVC是由Google研发的实时低延迟语音转换解决方案,能够在保持源语音内容和韵律的同时,匹配目标语音的音色。该技术特别适合实时通信场景,如...

StreamVCStreamVC是由Google研发的实时低延迟语音转换解决方案,能够在保持源语音内容和韵律的同时,匹配目标语音的音色。该技术特别适合实时通信场景,如... -

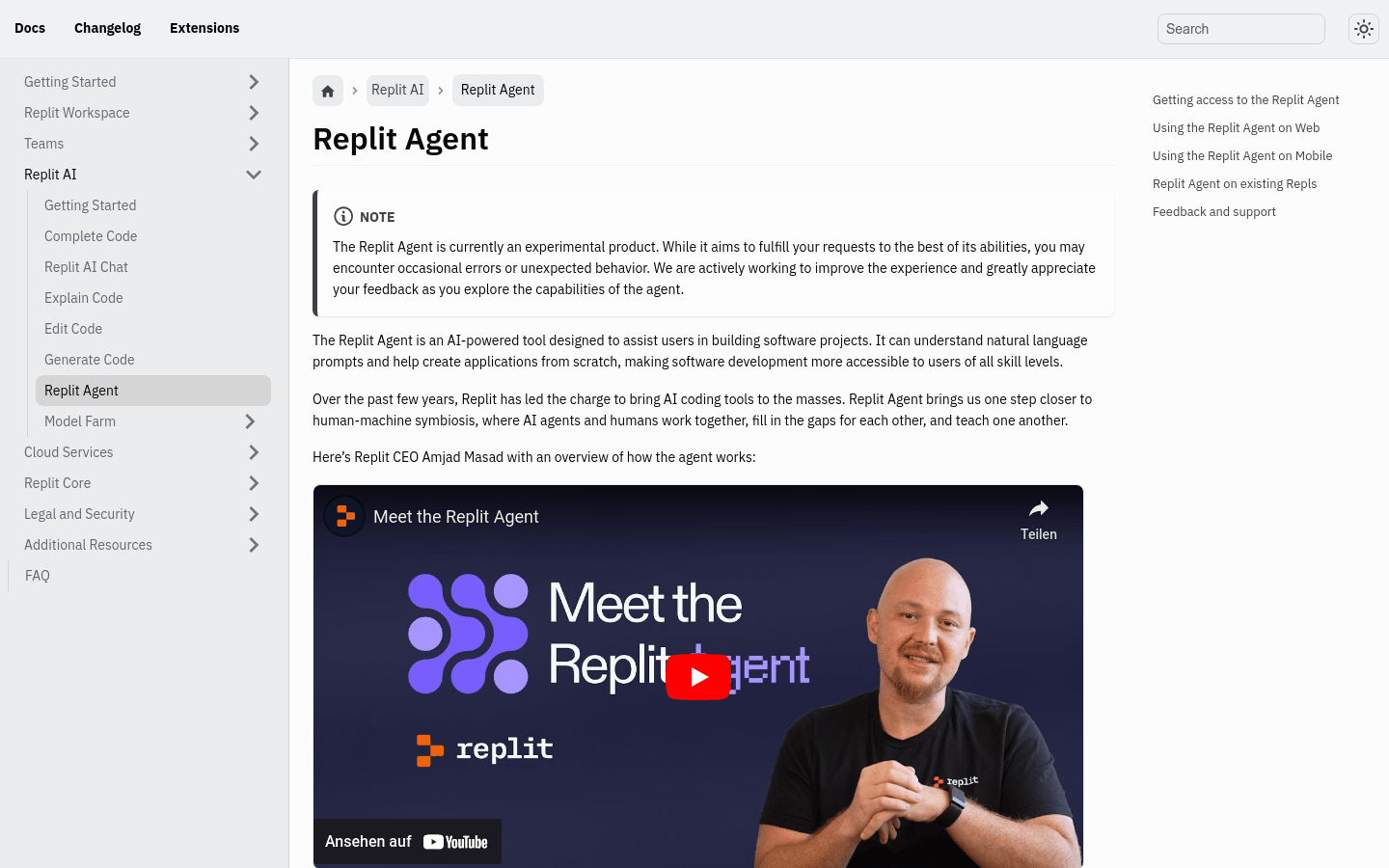

Replit AgentReplit Agent是一个AI驱动的工具,旨在帮助用户构建软件项目。它能够理解自然语言提示,并协助从头开始创建应用程序,使得软件开发对所有技能水平...

Replit AgentReplit Agent是一个AI驱动的工具,旨在帮助用户构建软件项目。它能够理解自然语言提示,并协助从头开始创建应用程序,使得软件开发对所有技能水平... -

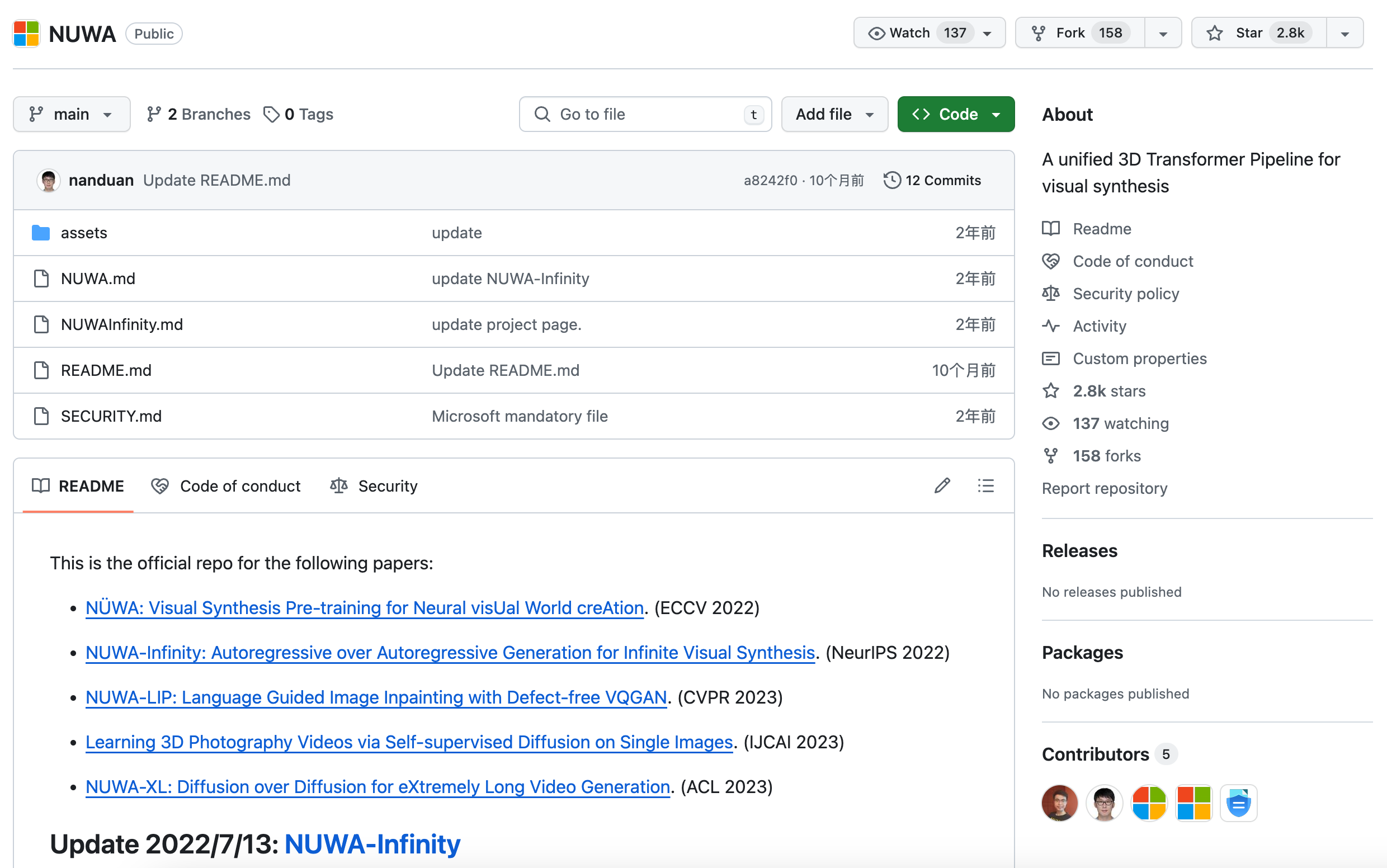

NUWANUWA是由微软开发的一系列研究项目,包括NUWA、NUWA-Infinity、NUWA-LIP、Learning 3D Photography Vi...

NUWANUWA是由微软开发的一系列研究项目,包括NUWA、NUWA-Infinity、NUWA-LIP、Learning 3D Photography Vi... -

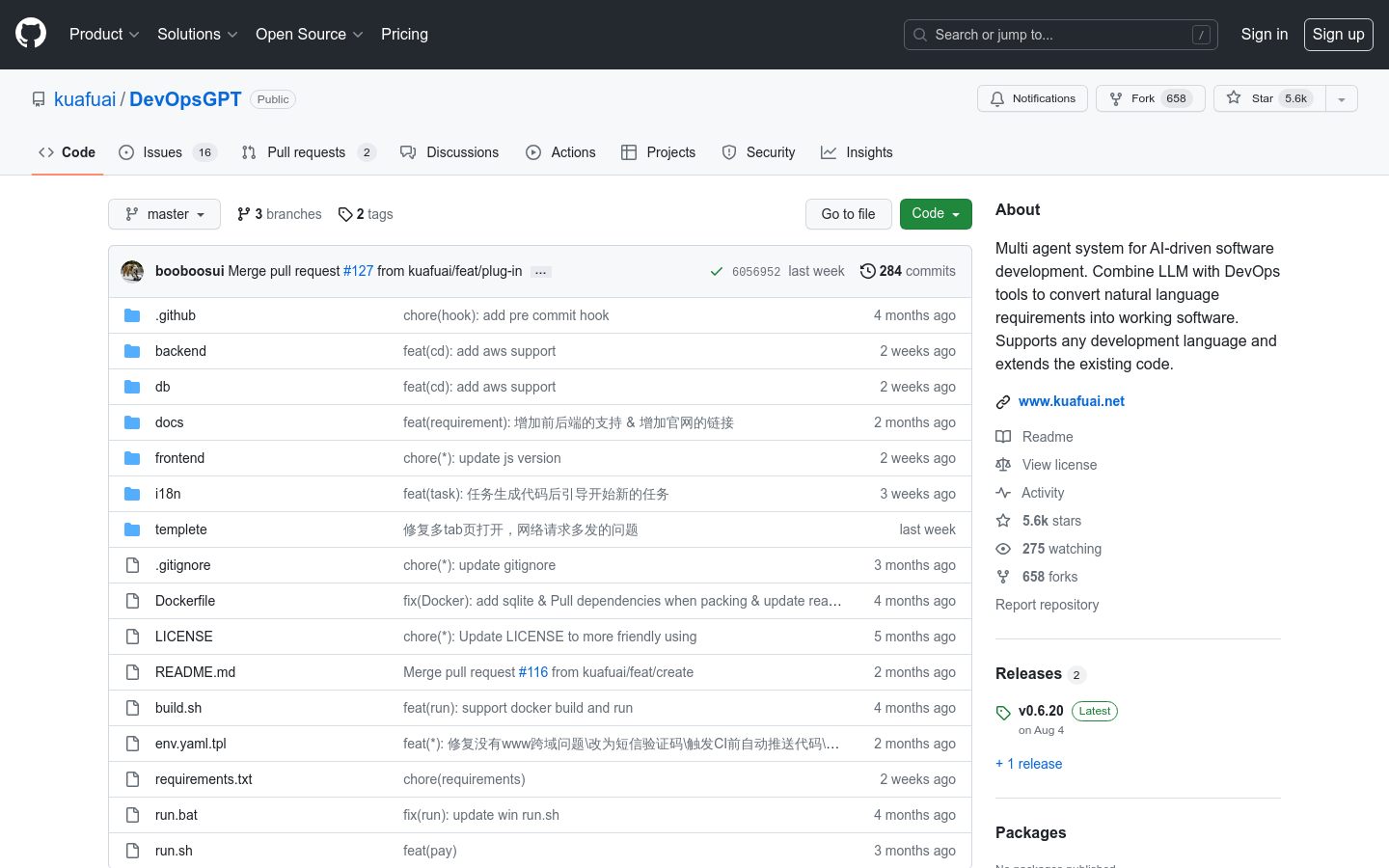

DevOpsGPTDevOpsGPT是一个AI驱动的软件自动化开发解决方案,它结合了大型语言模型和DevOps工具,可以将自然语言需求转换成可工作的软件。该解决方案大大...

DevOpsGPTDevOpsGPT是一个AI驱动的软件自动化开发解决方案,它结合了大型语言模型和DevOps工具,可以将自然语言需求转换成可工作的软件。该解决方案大大... -

IndieTeamzIndieTeamz是一个连接志同道合的人的平台,帮助他们设计、开发和推广独特的产品。该平台提供了各种角色和专业技能的人才,以便团队可以完善地合作开发...

IndieTeamzIndieTeamz是一个连接志同道合的人的平台,帮助他们设计、开发和推广独特的产品。该平台提供了各种角色和专业技能的人才,以便团队可以完善地合作开发... -

SummioSummio是一款基于AI的销售自动化工具,能够自动化销售过程中的潜在客户开发、资格认定和会议安排,帮助销售团队提高效率。它能够根据潜在客户在网上的信...

SummioSummio是一款基于AI的销售自动化工具,能够自动化销售过程中的潜在客户开发、资格认定和会议安排,帮助销售团队提高效率。它能够根据潜在客户在网上的信... -

Gemini 1.5 ProGemini 1.5 Pro是Google开发者平台推出的下一代AI模型,支持语音理解、系统指令、JSON输出等新功能,并推出了新一代文本嵌入模型Ge...

Gemini 1.5 ProGemini 1.5 Pro是Google开发者平台推出的下一代AI模型,支持语音理解、系统指令、JSON输出等新功能,并推出了新一代文本嵌入模型Ge... -

ShellGPTshell_gpt利用AI大型语言模型的强大能力,通过命令行界面提供辅助,使用户能够通过自然语言指令来执行任务,提高工作效率和效率。...

ShellGPTshell_gpt利用AI大型语言模型的强大能力,通过命令行界面提供辅助,使用户能够通过自然语言指令来执行任务,提高工作效率和效率。... -

Dev HomeDev Home是微软为Windows开发者推出的一款桌面客户端,旨在提供一个集中的控制中心,帮助开发者监控项目、设置开发环境、连接开发者账户和工具,...

Dev HomeDev Home是微软为Windows开发者推出的一款桌面客户端,旨在提供一个集中的控制中心,帮助开发者监控项目、设置开发环境、连接开发者账户和工具,... -

ReactAI ComponentsReactAI Components是一个利用人工智能技术帮助开发者快速构建React组件的平台。它通过集成先进的AI模型,如Claude/Anthr...

ReactAI ComponentsReactAI Components是一个利用人工智能技术帮助开发者快速构建React组件的平台。它通过集成先进的AI模型,如Claude/Anthr...

卓商AI

AI爱好者的一站式人工智能AI工具箱,累计收录全球10,000⁺好用的AI工具软件和网站,方便您更便捷的探索前沿的AI技术。本站持续更新好的AI应用,力争做全球排名前三的AI网址导航网站,欢迎您成为我们的一员。

最新收录

Spoke

Spoke是一款AI插件,为产品经理提供强大的、注重隐私的AI功能,能够在几秒钟内为用户提供上下文信息。它可以帮助全球快速增长的团队节省时间,创造上下...

LastMile AI

LastMile AI是一个AI开发平台,专为工程师而设计,可以用于原型开发和生成式AI应用的生产。它提供了一站式的多模态AI模型访问,包括语言模型(...

Dokkio

Dokkio是一款利用人工智能技术提供云文件协作的工具。它能帮助用户管理多个活动、搜索文档和文件、整理研究材料、组织内容库,并将所有文件和内容集中在一...

Engage Sphere AI

Engage Sphere是一个基于AI的员工参与度分析平台。它可以深入分析公司各个部门、团队和岗位的参与度,帮助管理者明确团队互动症结所在,并采取行...

Pikzels

Pikzels连接顶级人才和有远见的客户。我们促进协作,释放创意卓越。加入我们,获取来自各个领域的优秀专业人才。体验协作的力量,释放你的创意潜能。Pi...

Zoho Cliq

Zoho Cliq是一款专为提高企业工作效率而设计的在线即时通讯和协作平台。它将团队成员、对话和工作流集中在一个地方,实现无缝连接。主要功能包括:组织...

猜你喜欢

PromptPuzzle.Ai

PromptPuzzle.ai是一个基于提示拼图的解谜游戏,你需要根据给出的提示来拼凑图像。这个游戏挑战你的逻辑思维和创造力,让你体验到像人工智能一样...

Openjourney Bot

Openjourney是一个强大的Discord机器人,免费生成AI艺术。使用/imagine命令,根据文本提示在10秒内生成图像。Openjourn...

relayto ai

Relayto AI是一种革命性的工具,它使用高级算法将PDF转换为交互式数字内容。在不需要编码或AI的情况下增强客户体验24/7。通过动态的微型镜来...

RevFX

RevFX是一个商业智能平台,专注于通过AI技术帮助企业发现、筛选和优先处理潜在客户账户。它通过分析公共网络、第三方数据提供商和企业自身的GTM系统上...

Create a Meme

Create a Meme是一个直观的梗图创建工具,用户可以使用该工具来创建自定义的梗图,并与他人分享。该工具提供了丰富的模板和编辑功能,使用户能够轻...

lisapet ai

引入Lisapet.ai- Premier AI产品开发平台。使用Lisapet.ai,团队可以在创纪录的时间内毫不费力地进行原型,测试和高级AI功能...

最新文章

1

2

3

4

5

6

7

8

9

10