相关AI工具集

-

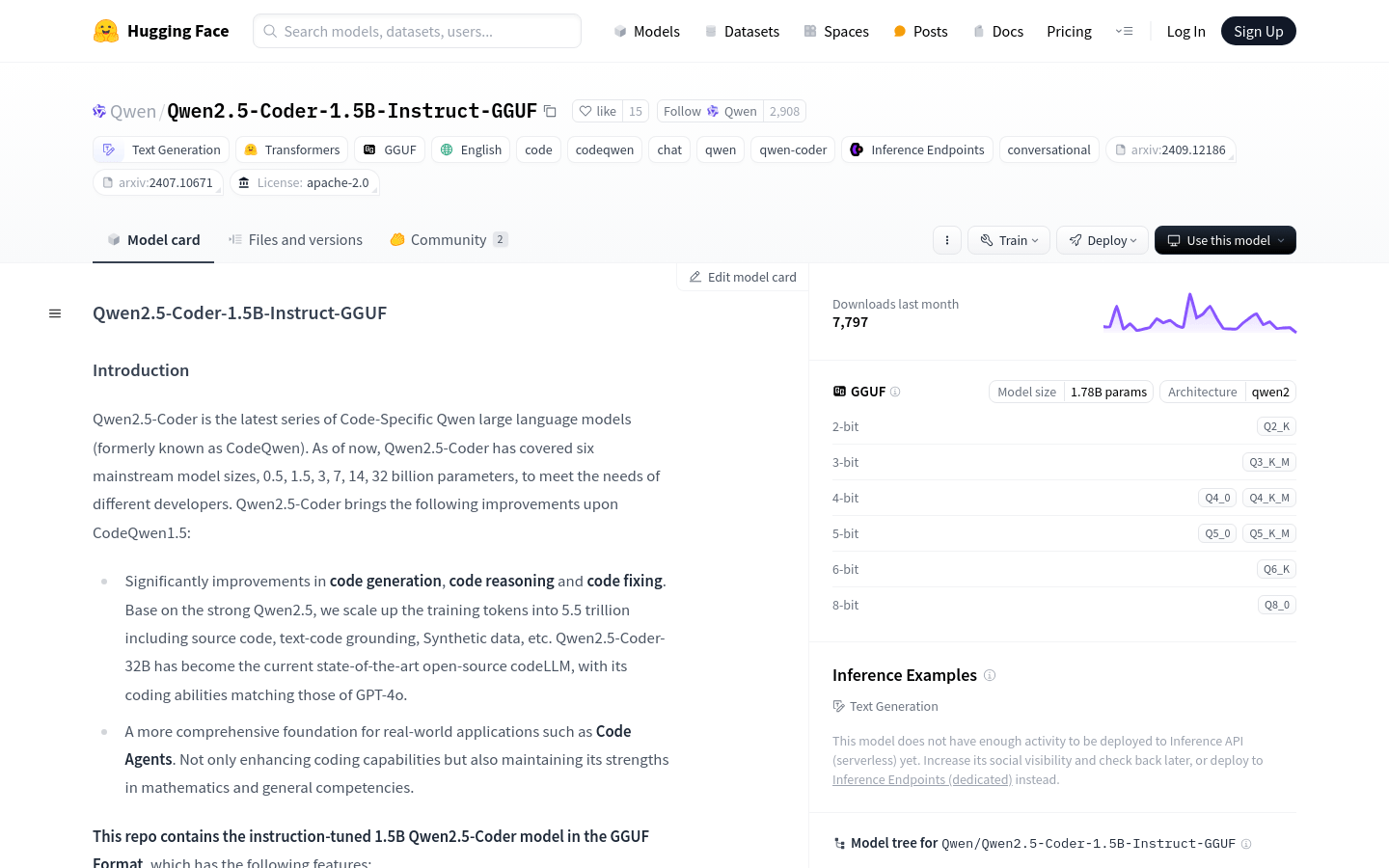

Qwen2.5-Coder-1.5B-Instruct-GGUFQwen2.5-Coder是Qwen大型语言模型的最新系列,专为代码生成、代码推理和代码修复而设计。基于强大的Qwen2.5,通过增加训练令牌至5.5...

Qwen2.5-Coder-1.5B-Instruct-GGUFQwen2.5-Coder是Qwen大型语言模型的最新系列,专为代码生成、代码推理和代码修复而设计。基于强大的Qwen2.5,通过增加训练令牌至5.5... -

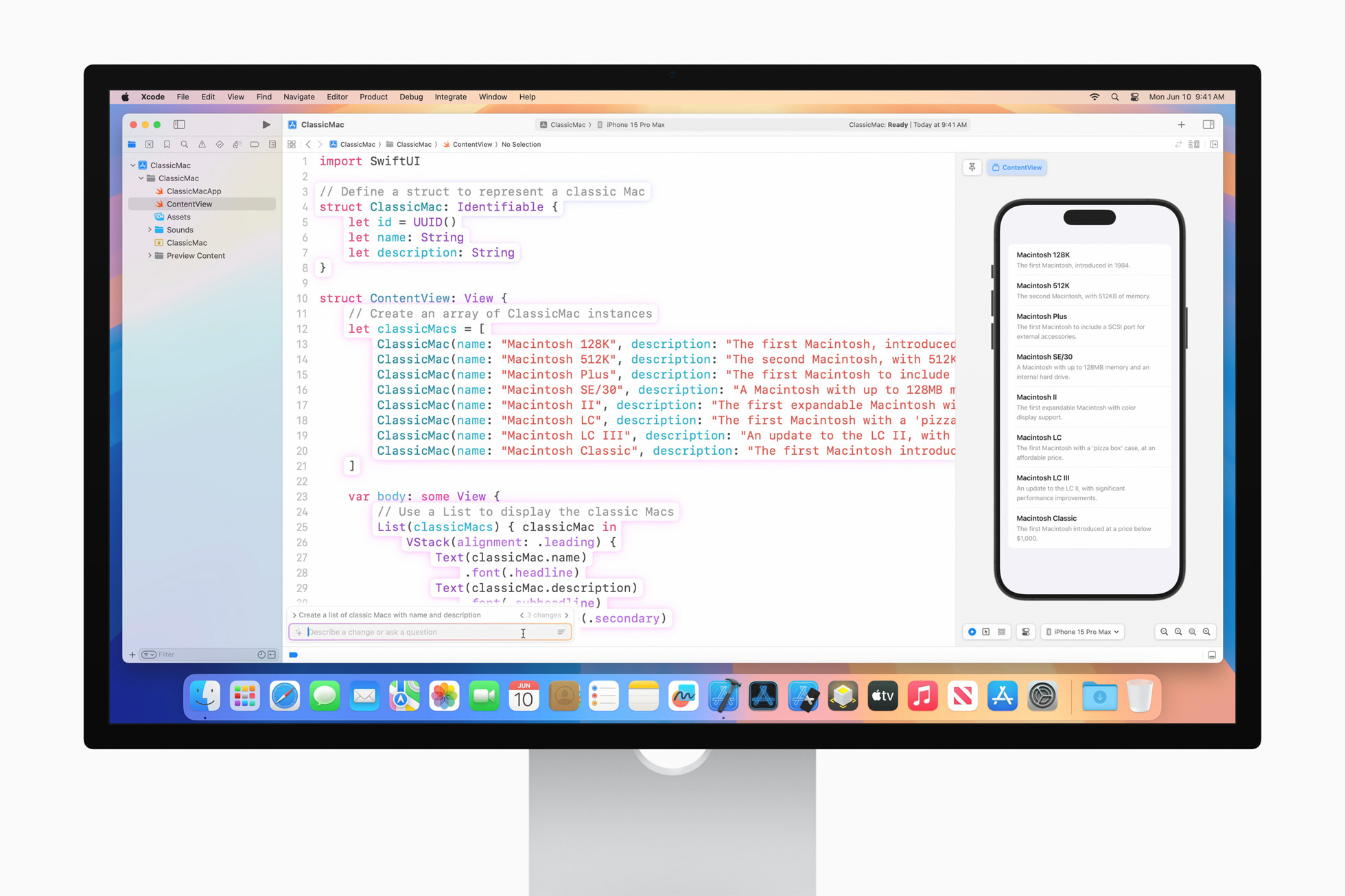

Xcode 16Xcode 16 提供了功能和性能提升,助力开发者以比以往更快的速度构建出色的 app,提升开发者的生产力标准。Xcode 16 带来了全新的预测性代...

Xcode 16Xcode 16 提供了功能和性能提升,助力开发者以比以往更快的速度构建出色的 app,提升开发者的生产力标准。Xcode 16 带来了全新的预测性代... -

OmniParser V2OmniParser V2 是微软研究团队开发的一种先进的人工智能模型,旨在将大型语言模型(LLM)转化为能够理解和操作图形用户界面(GUI)的智能代...

OmniParser V2OmniParser V2 是微软研究团队开发的一种先进的人工智能模型,旨在将大型语言模型(LLM)转化为能够理解和操作图形用户界面(GUI)的智能代... -

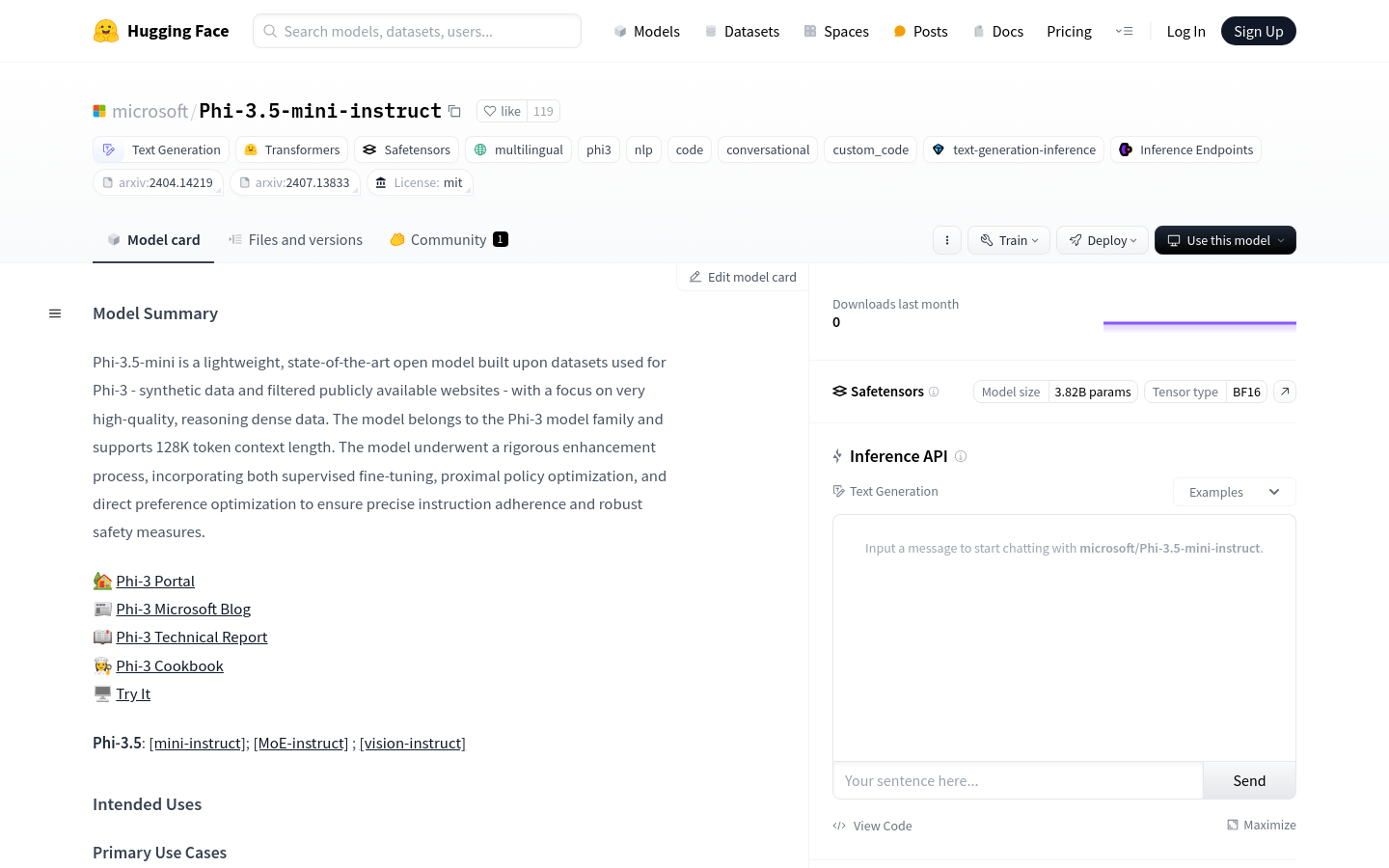

Phi-3.5-mini-instructPhi-3.5-mini-instruct 是微软基于高质量数据构建的轻量级、多语言的先进文本生成模型。它专注于提供高质量的推理密集型数据,支持128...

Phi-3.5-mini-instructPhi-3.5-mini-instruct 是微软基于高质量数据构建的轻量级、多语言的先进文本生成模型。它专注于提供高质量的推理密集型数据,支持128... -

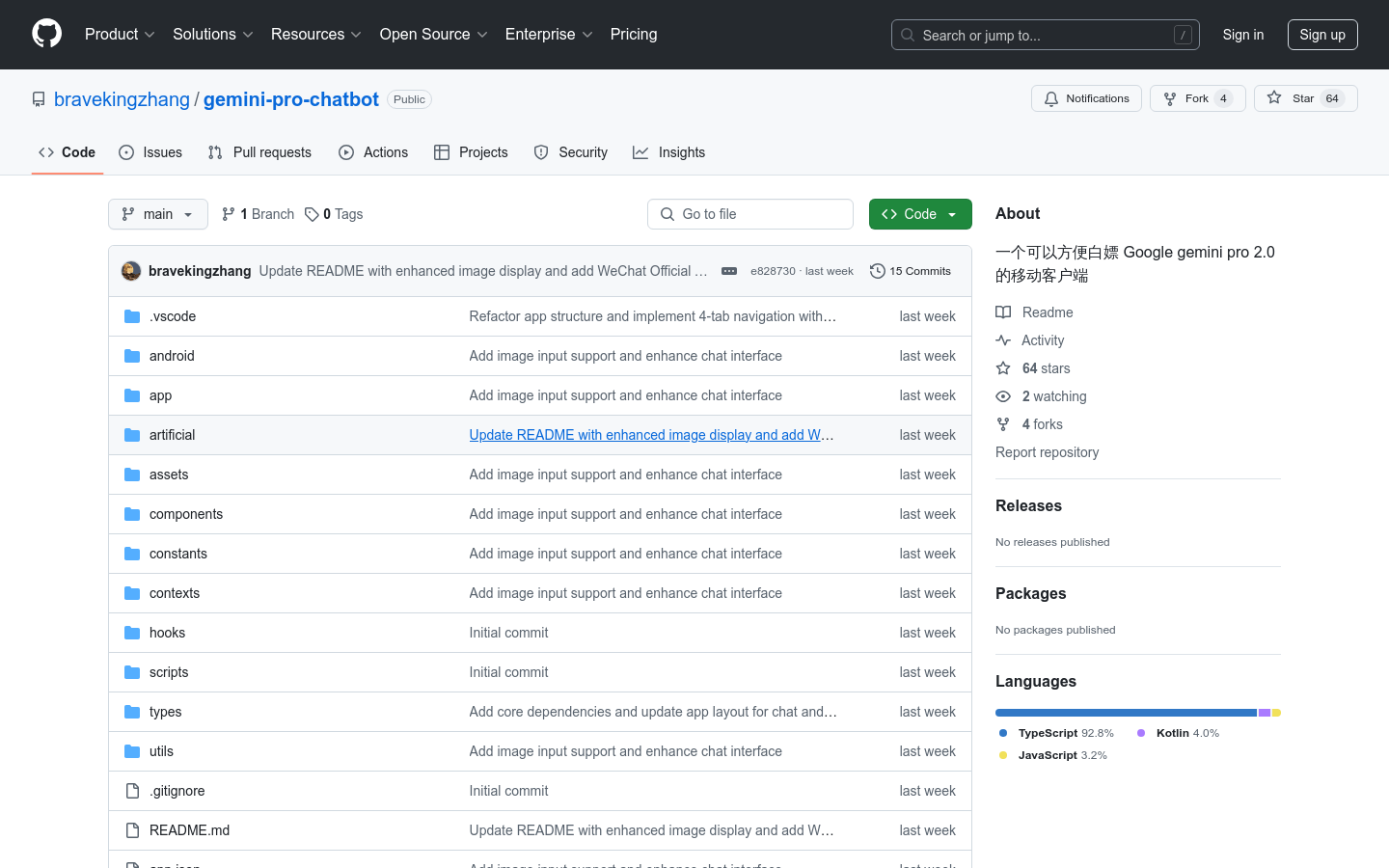

Gemini Pro ChatbotGemini Pro Chatbot 是一款基于 Google Gemini Pro AI 模型开发的移动聊天应用。它通过 React Native ...

Gemini Pro ChatbotGemini Pro Chatbot 是一款基于 Google Gemini Pro AI 模型开发的移动聊天应用。它通过 React Native ... -

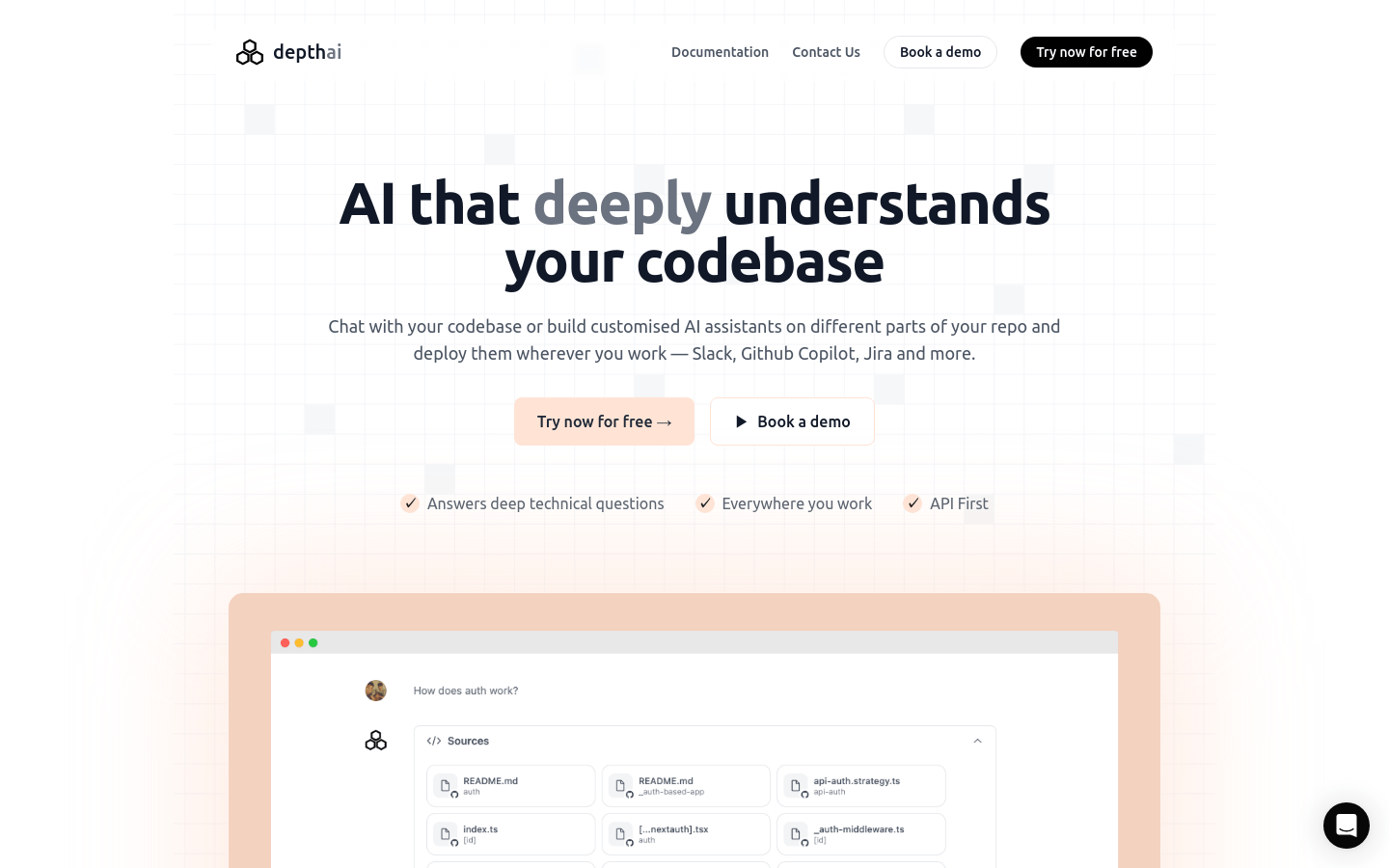

Depth AIDepth AI 是一款由工程师构建的人工智能产品,它通过构建代码库的知识图谱,能够回答深度技术问题,并支持在不同工作场景中部署定制化的AI助手。产品...

Depth AIDepth AI 是一款由工程师构建的人工智能产品,它通过构建代码库的知识图谱,能够回答深度技术问题,并支持在不同工作场景中部署定制化的AI助手。产品... -

Smolagents.orgSmolagents是Hugging Face团队开发的极简AI代理框架,旨在让开发者仅用少量代码就能部署强大的代理。它专注于代码代理,即代理通过编写...

Smolagents.orgSmolagents是Hugging Face团队开发的极简AI代理框架,旨在让开发者仅用少量代码就能部署强大的代理。它专注于代码代理,即代理通过编写... -

AtworkAtwork 是一款专注于提升团队工作效率的无代码工作操作系统。它通过灵活的数据管理、智能表格、自动化工作流等功能,帮助企业和团队简化复杂的业务流程,...

AtworkAtwork 是一款专注于提升团队工作效率的无代码工作操作系统。它通过灵活的数据管理、智能表格、自动化工作流等功能,帮助企业和团队简化复杂的业务流程,... -

Alice 3.0Alice 是一款个人 AI 助手应用程序,旨在通过不同的 AI 模型提高用户的工作效率。它集成了最新的 AI 技术,支持自动化工作流,使用户可以更轻...

Alice 3.0Alice 是一款个人 AI 助手应用程序,旨在通过不同的 AI 模型提高用户的工作效率。它集成了最新的 AI 技术,支持自动化工作流,使用户可以更轻... -

Cursor 101Cursor是一个AI驱动的代码编辑器,它通过集成先进的人工智能技术,帮助开发者提高编码效率,降低编程入门门槛,同时提升代码质量和加速创新。Curso...

Cursor 101Cursor是一个AI驱动的代码编辑器,它通过集成先进的人工智能技术,帮助开发者提高编码效率,降低编程入门门槛,同时提升代码质量和加速创新。Curso... -

InferableInferable 是一个专注于内部运营的对话式 AI 代理平台,旨在帮助企业和团队整合内部系统、碎片化代码库和一次性脚本。通过对话式代理,企业可以减...

InferableInferable 是一个专注于内部运营的对话式 AI 代理平台,旨在帮助企业和团队整合内部系统、碎片化代码库和一次性脚本。通过对话式代理,企业可以减... -

Qwen2.5-Coder-3B-Instruct-GGUFQwen2.5-Coder是Qwen大型语言模型的最新系列,专注于代码生成、代码推理和代码修复。基于强大的Qwen2.5,训练令牌扩展到5.5万亿,包...

Qwen2.5-Coder-3B-Instruct-GGUFQwen2.5-Coder是Qwen大型语言模型的最新系列,专注于代码生成、代码推理和代码修复。基于强大的Qwen2.5,训练令牌扩展到5.5万亿,包...

卓商AI

AI爱好者的一站式人工智能AI工具箱,累计收录全球10,000⁺好用的AI工具软件和网站,方便您更便捷的探索前沿的AI技术。本站持续更新好的AI应用,力争做全球排名前三的AI网址导航网站,欢迎您成为我们的一员。

最新收录

Spoke

Spoke是一款AI插件,为产品经理提供强大的、注重隐私的AI功能,能够在几秒钟内为用户提供上下文信息。它可以帮助全球快速增长的团队节省时间,创造上下...

LastMile AI

LastMile AI是一个AI开发平台,专为工程师而设计,可以用于原型开发和生成式AI应用的生产。它提供了一站式的多模态AI模型访问,包括语言模型(...

Dokkio

Dokkio是一款利用人工智能技术提供云文件协作的工具。它能帮助用户管理多个活动、搜索文档和文件、整理研究材料、组织内容库,并将所有文件和内容集中在一...

Engage Sphere AI

Engage Sphere是一个基于AI的员工参与度分析平台。它可以深入分析公司各个部门、团队和岗位的参与度,帮助管理者明确团队互动症结所在,并采取行...

Pikzels

Pikzels连接顶级人才和有远见的客户。我们促进协作,释放创意卓越。加入我们,获取来自各个领域的优秀专业人才。体验协作的力量,释放你的创意潜能。Pi...

Zoho Cliq

Zoho Cliq是一款专为提高企业工作效率而设计的在线即时通讯和协作平台。它将团队成员、对话和工作流集中在一个地方,实现无缝连接。主要功能包括:组织...

猜你喜欢

bekiai

Bekiai通过AI技术轻松地进行内部联系。与乏味的搜索操作员和电子表格说再见。该工具可帮助您轻松地查找,添加和跟踪内部链接,从而简化内容优化过程。增...

NVIDIA App

NVIDIA App 是一款专为PC游戏玩家和创作者设计的应用程序,它可以帮助用户及时升级到最新的NVIDIA驱动程序和技术。通过统一的GPU控制中心...

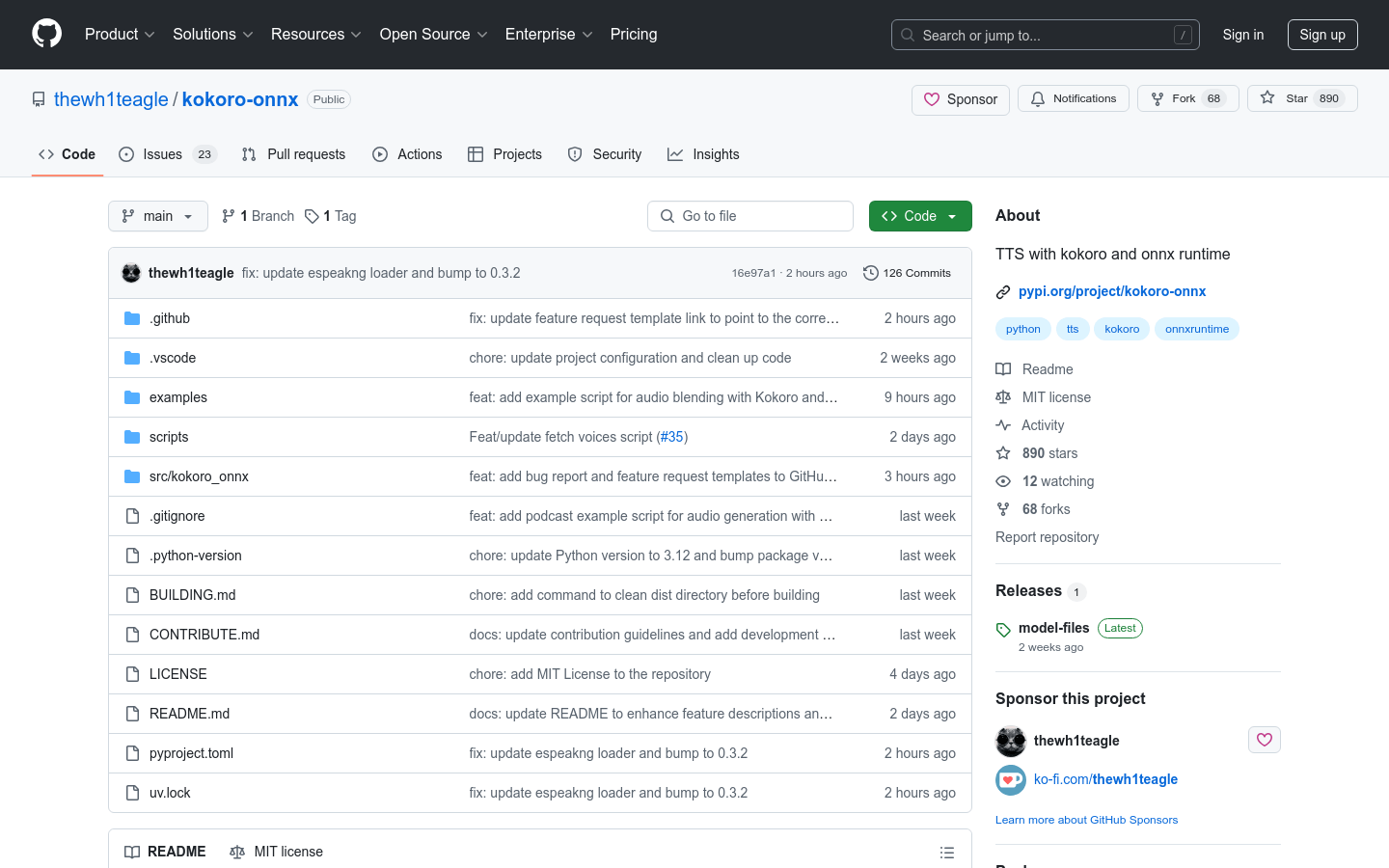

kokoro-onnx

kokoro-onnx是一个基于Kokoro模型和ONNX运行时的文本到语音(TTS)项目。它支持英语,并计划支持法语、日语、韩语和中文。该模型在ma...

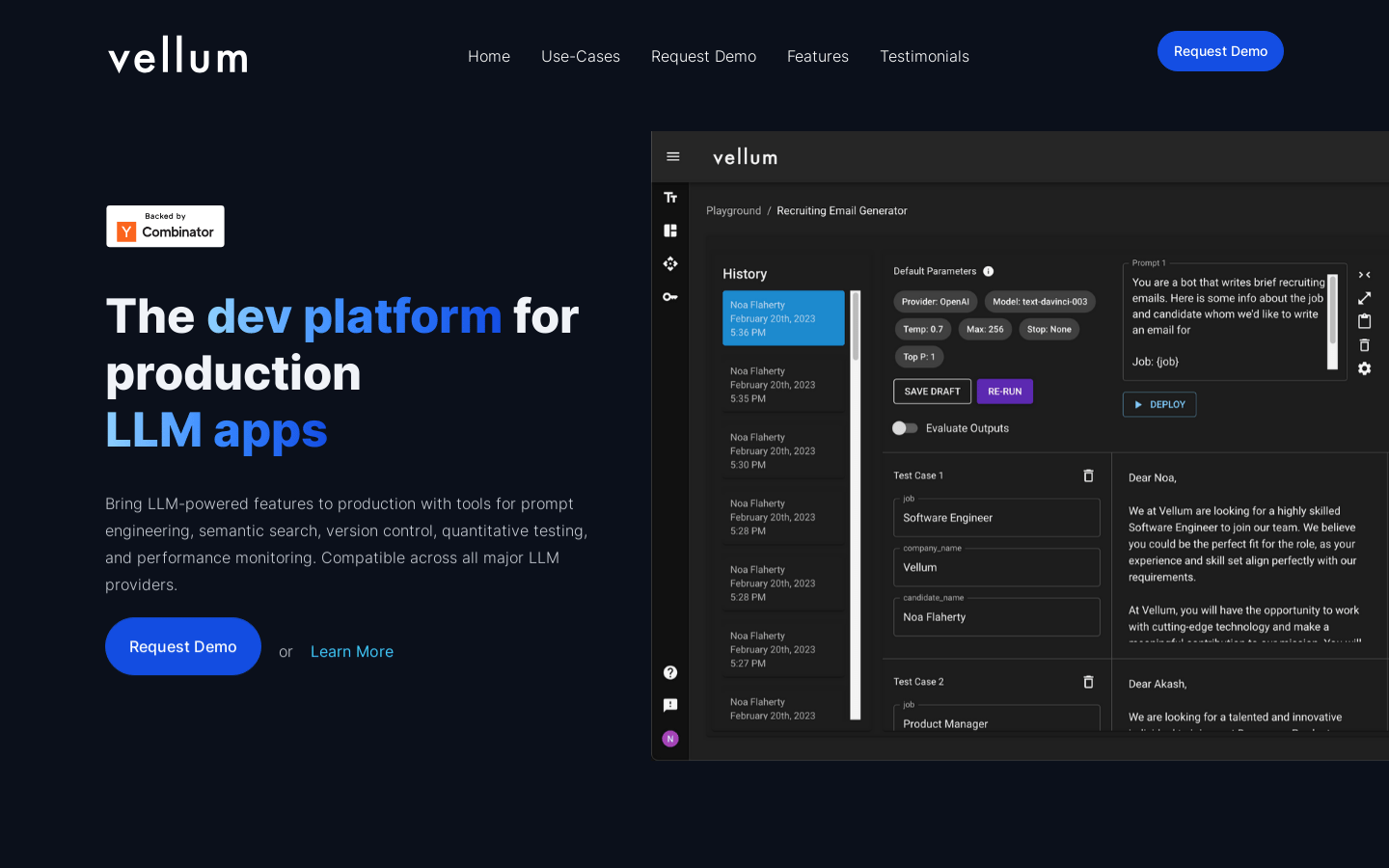

Vellum

Vellum 是一个开发平台,用于构建 LLM 应用。它提供了快速工程、语义搜索、版本控制、测试和监控等工具,兼容所有主要的 LLM 提供商。Vell...

trust

Trust提供了一个易于使用的平台,用于创建引人注目的视频推荐,以提高参与度和转化率。借助我们的多合一解决方案,您可以在几分钟内快速而轻松地将外部评论...

Pictioner

Pictioner是一个有趣的猜图游戏,用户需要在画布上的三次尝试内猜出GPT所画的东西。用户通过猜对或者在三次内猜错来进行下一轮。准备好享受无尽的乐...

最新文章

1

2

3

4

5

6

7

8

9

10