相关AI工具集

-

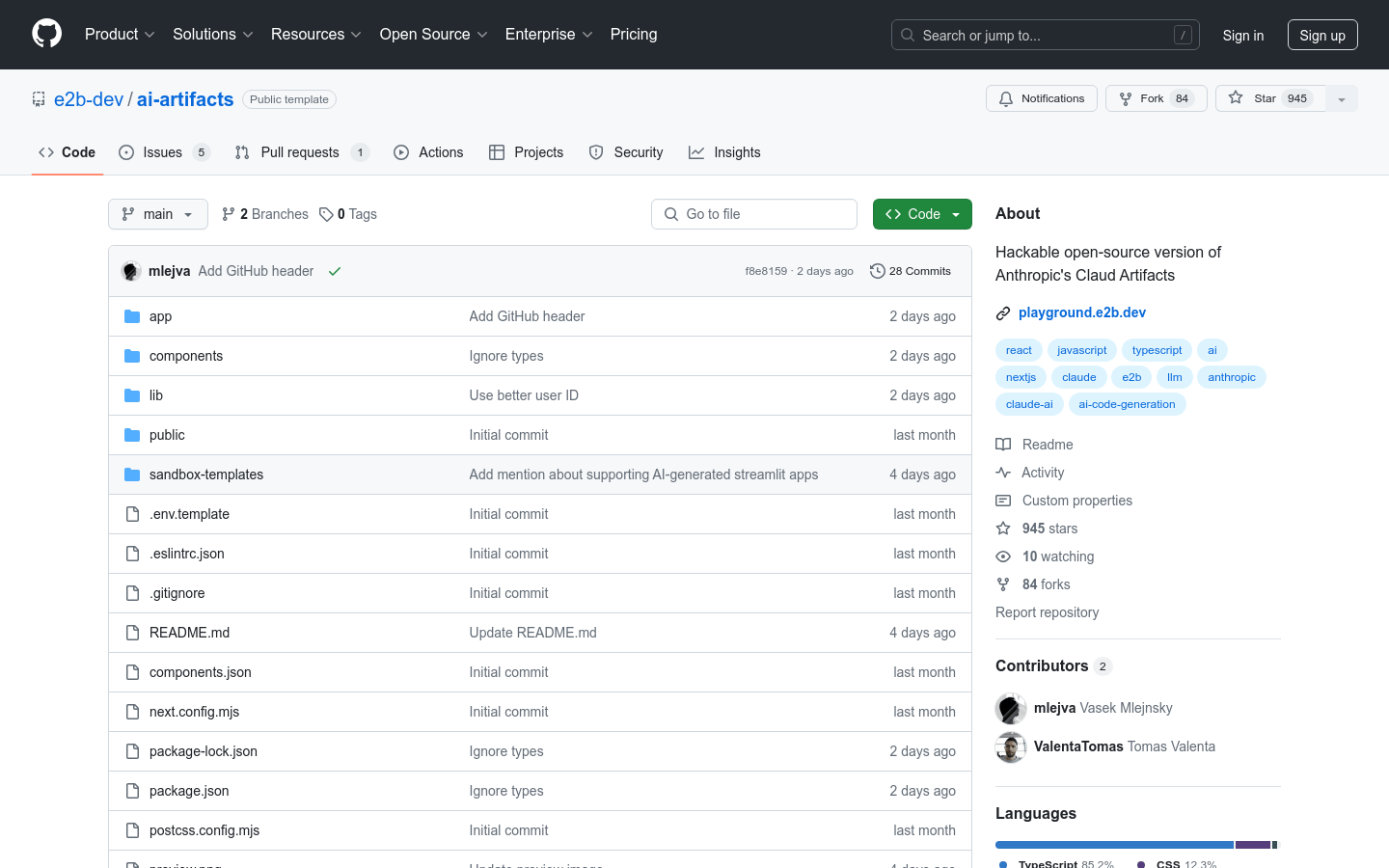

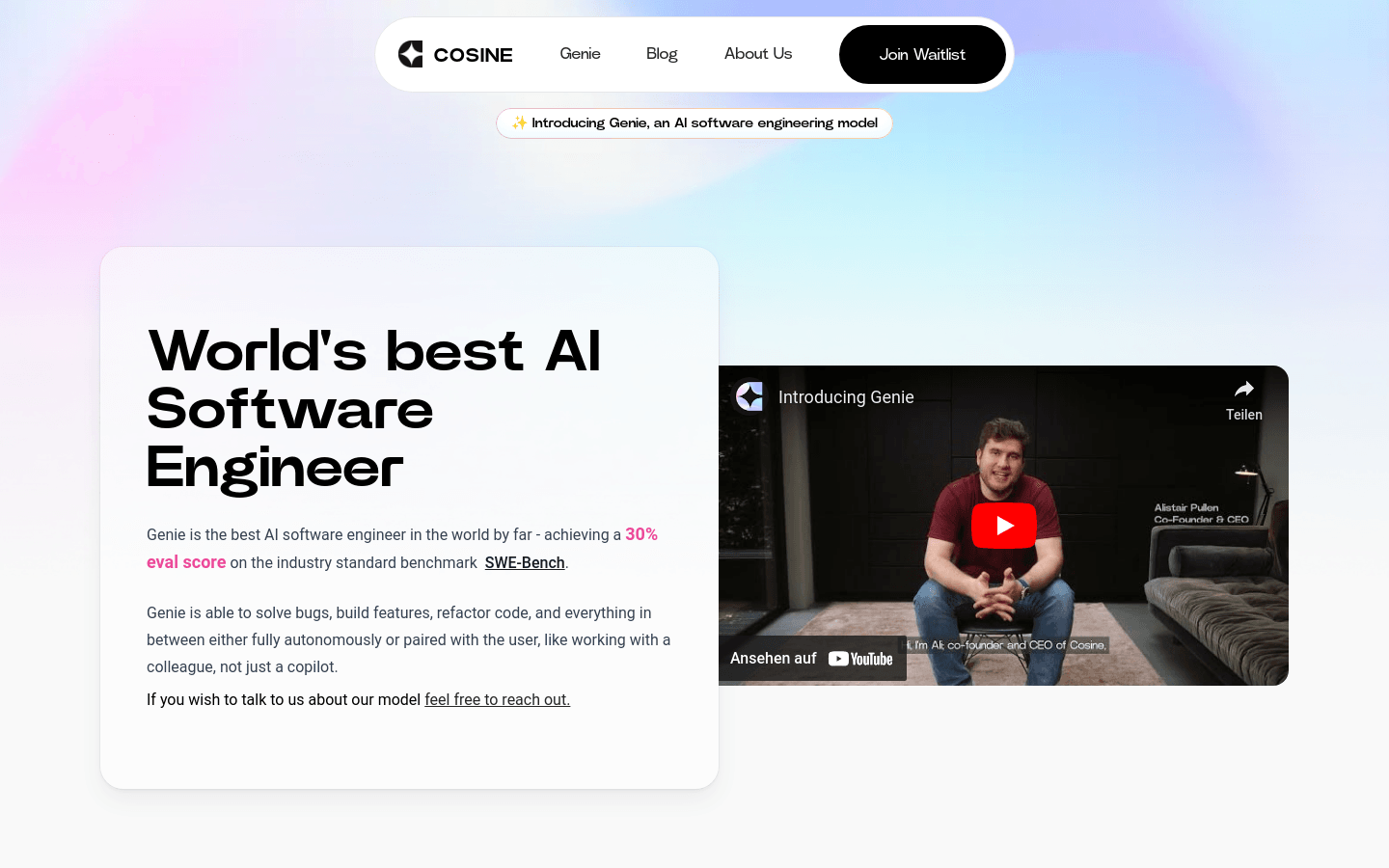

GenieGenie是一款AI软件工程模型,它在SWE-Bench行业标准基准测试中取得了30%的评估分数,远超其他同类产品。Genie能够独立或与用户协作解决...

GenieGenie是一款AI软件工程模型,它在SWE-Bench行业标准基准测试中取得了30%的评估分数,远超其他同类产品。Genie能够独立或与用户协作解决... -

Monokai ProMonokai Pro 是一款专为代码编辑器设计的配色方案、用户界面主题和图标包。它由 Wimer Hazenberg 在 2006 年创建,迅速成为...

Monokai ProMonokai Pro 是一款专为代码编辑器设计的配色方案、用户界面主题和图标包。它由 Wimer Hazenberg 在 2006 年创建,迅速成为... -

豆包 MarsCode 代码练习豆包 MarsCode 是一款面向编程学习者的在线代码练习平台。它通过整合先进的AI技术和全功能代码编辑器,为用户提供了一个高效、实用的学习环境。该平...

豆包 MarsCode 代码练习豆包 MarsCode 是一款面向编程学习者的在线代码练习平台。它通过整合先进的AI技术和全功能代码编辑器,为用户提供了一个高效、实用的学习环境。该平... -

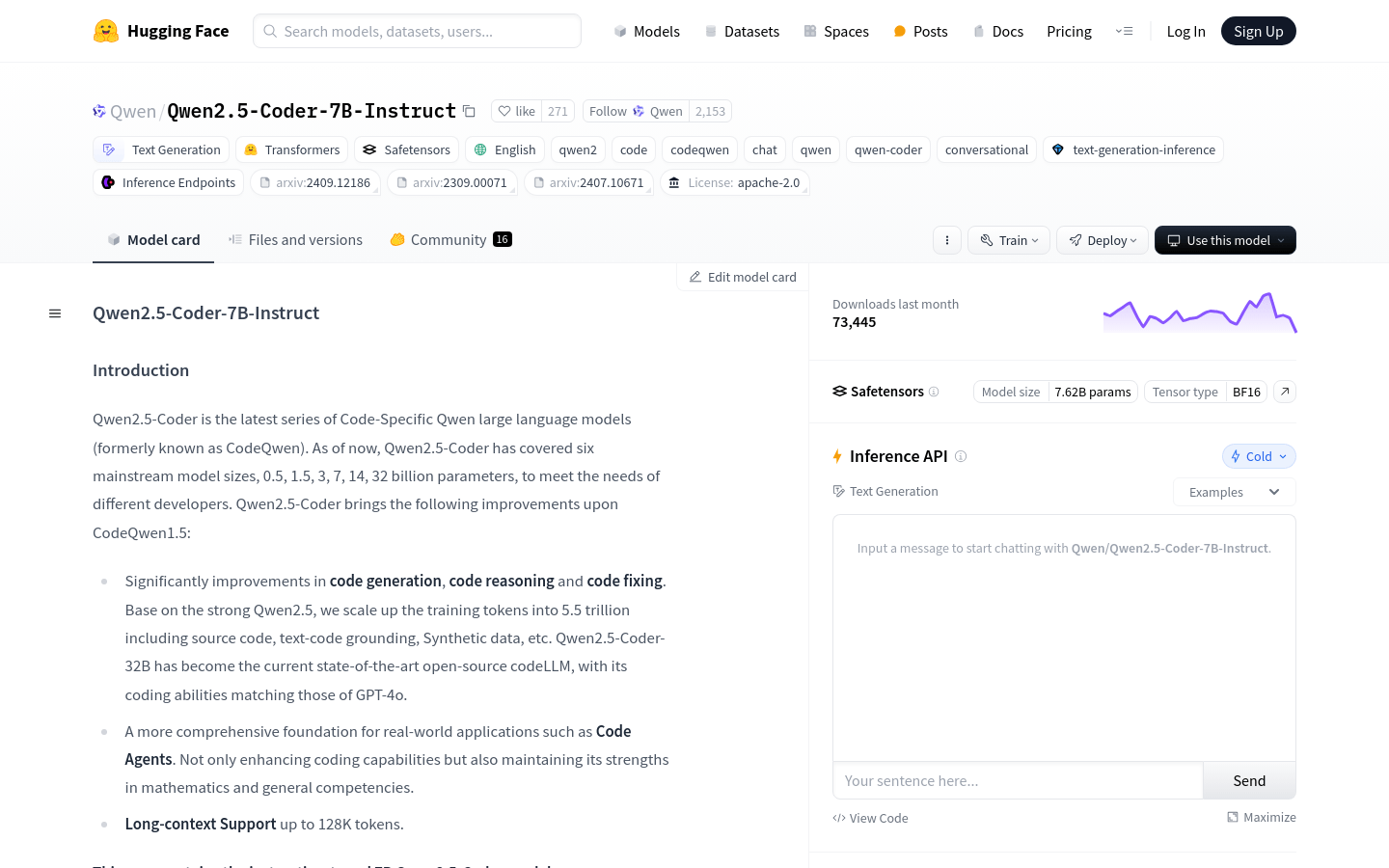

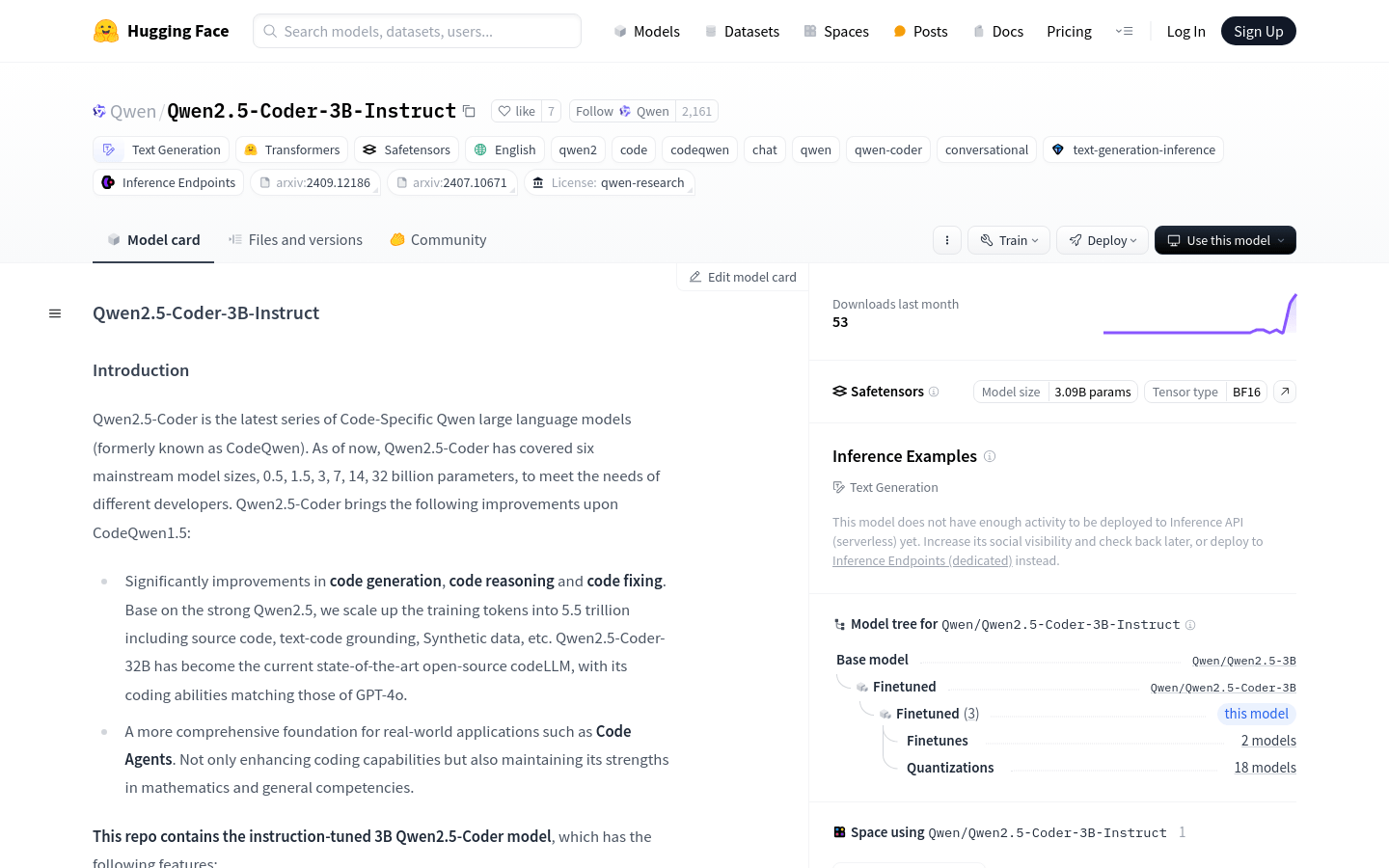

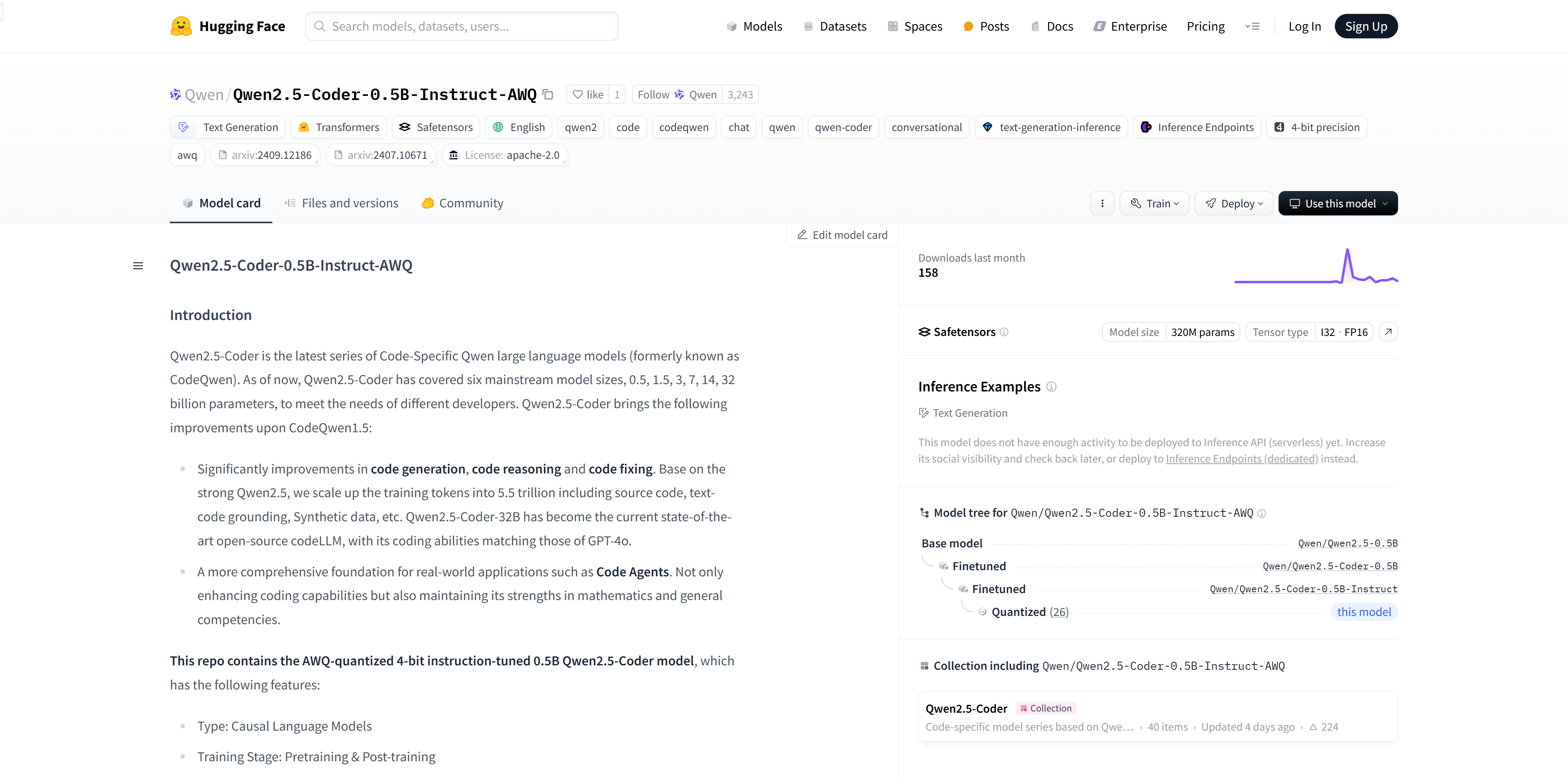

Qwen2.5-Coder-0.5B-Instruct-AWQQwen2.5-Coder是Qwen大型语言模型的最新系列,专注于代码生成、代码推理和代码修复。基于Qwen2.5的强大能力,通过扩展训练令牌至5.5...

Qwen2.5-Coder-0.5B-Instruct-AWQQwen2.5-Coder是Qwen大型语言模型的最新系列,专注于代码生成、代码推理和代码修复。基于Qwen2.5的强大能力,通过扩展训练令牌至5.5... -

Java Q&A HubJava Q&A Hub是一个专门为Java编程爱好者设计的在线问答平台,它提供了一系列与Java编程相关的问题和解答。该平台专注于Java语言的各个...

Java Q&A HubJava Q&A Hub是一个专门为Java编程爱好者设计的在线问答平台,它提供了一系列与Java编程相关的问题和解答。该平台专注于Java语言的各个... -

小艺小艺是华为推出的智能助手,集成了自然语言处理和机器学习技术,能够提供聊天、写作、编程、翻译等多种功能。它基于深度学习模型,能够理解用户的问题并给出准确...

小艺小艺是华为推出的智能助手,集成了自然语言处理和机器学习技术,能够提供聊天、写作、编程、翻译等多种功能。它基于深度学习模型,能够理解用户的问题并给出准确... -

LovableLovable是一个创新的全栈工程平台,它允许用户通过自然语言描述自己的想法,快速将概念转化为功能完备的应用程序。这个平台以其超快速的开发流程、直观的...

LovableLovable是一个创新的全栈工程平台,它允许用户通过自然语言描述自己的想法,快速将概念转化为功能完备的应用程序。这个平台以其超快速的开发流程、直观的... -

LattaLatta是一个AI驱动的自动化错误修复工具,旨在帮助开发者节省查找和修复bug的时间。它通过记录用户会话并重放,让开发者能够快速定位问题并修复。La...

LattaLatta是一个AI驱动的自动化错误修复工具,旨在帮助开发者节省查找和修复bug的时间。它通过记录用户会话并重放,让开发者能够快速定位问题并修复。La... -

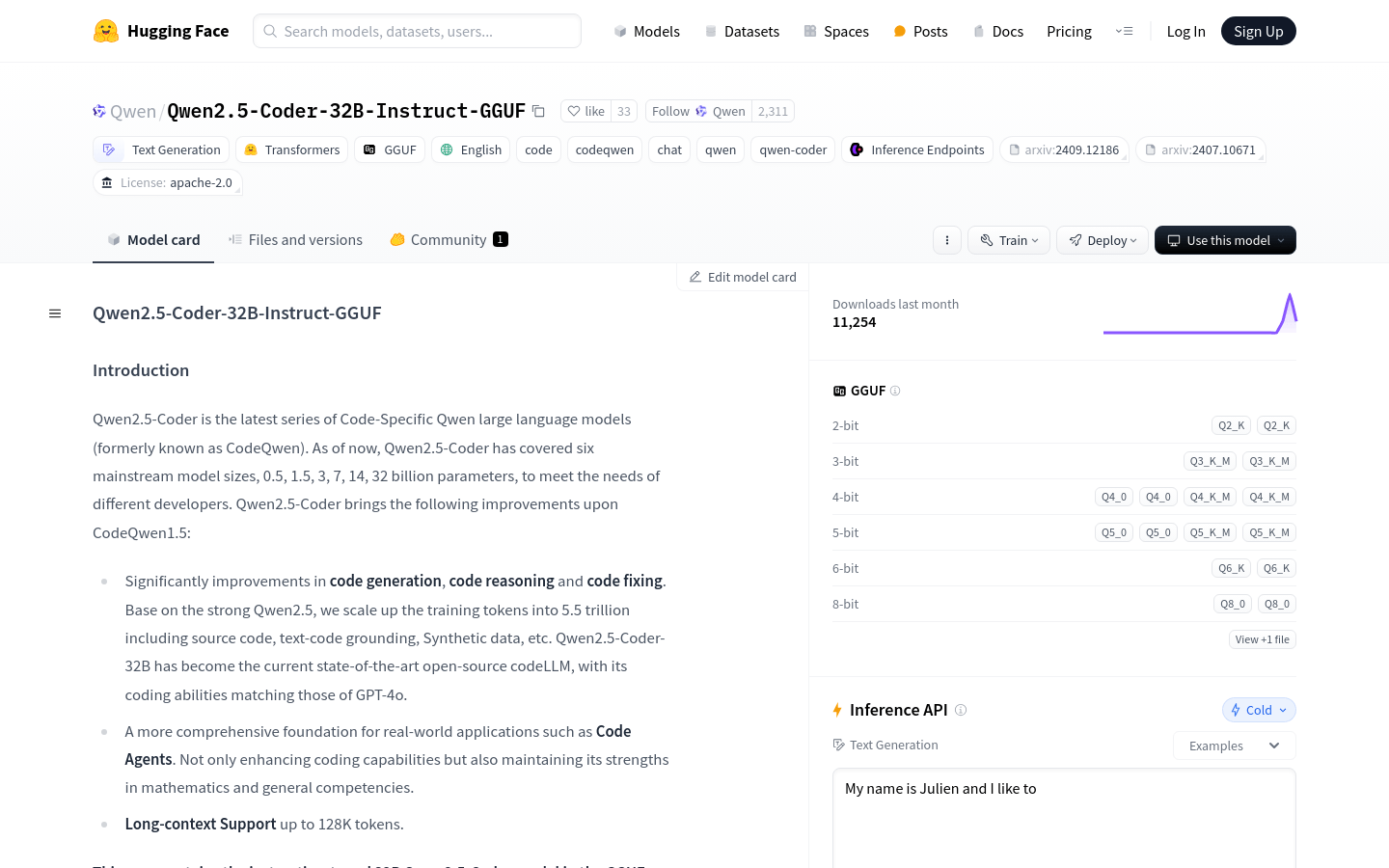

Qwen2.5-Coder-32B-Instruct-GGUFQwen2.5-Coder 是针对代码生成的模型,在代码生成等方面显著提升,参数规模多样,支持量化。免费,面向开发者提高效率和质量。...

Qwen2.5-Coder-32B-Instruct-GGUFQwen2.5-Coder 是针对代码生成的模型,在代码生成等方面显著提升,参数规模多样,支持量化。免费,面向开发者提高效率和质量。... -

BuildELBuildEL是一个无需编写代码即可构建AI工作流的平台,它通过提供多种模块和接口,支持用户快速搭建复杂的工作流程。该产品特别适合需要快速实现自动化任...

BuildELBuildEL是一个无需编写代码即可构建AI工作流的平台,它通过提供多种模块和接口,支持用户快速搭建复杂的工作流程。该产品特别适合需要快速实现自动化任... -

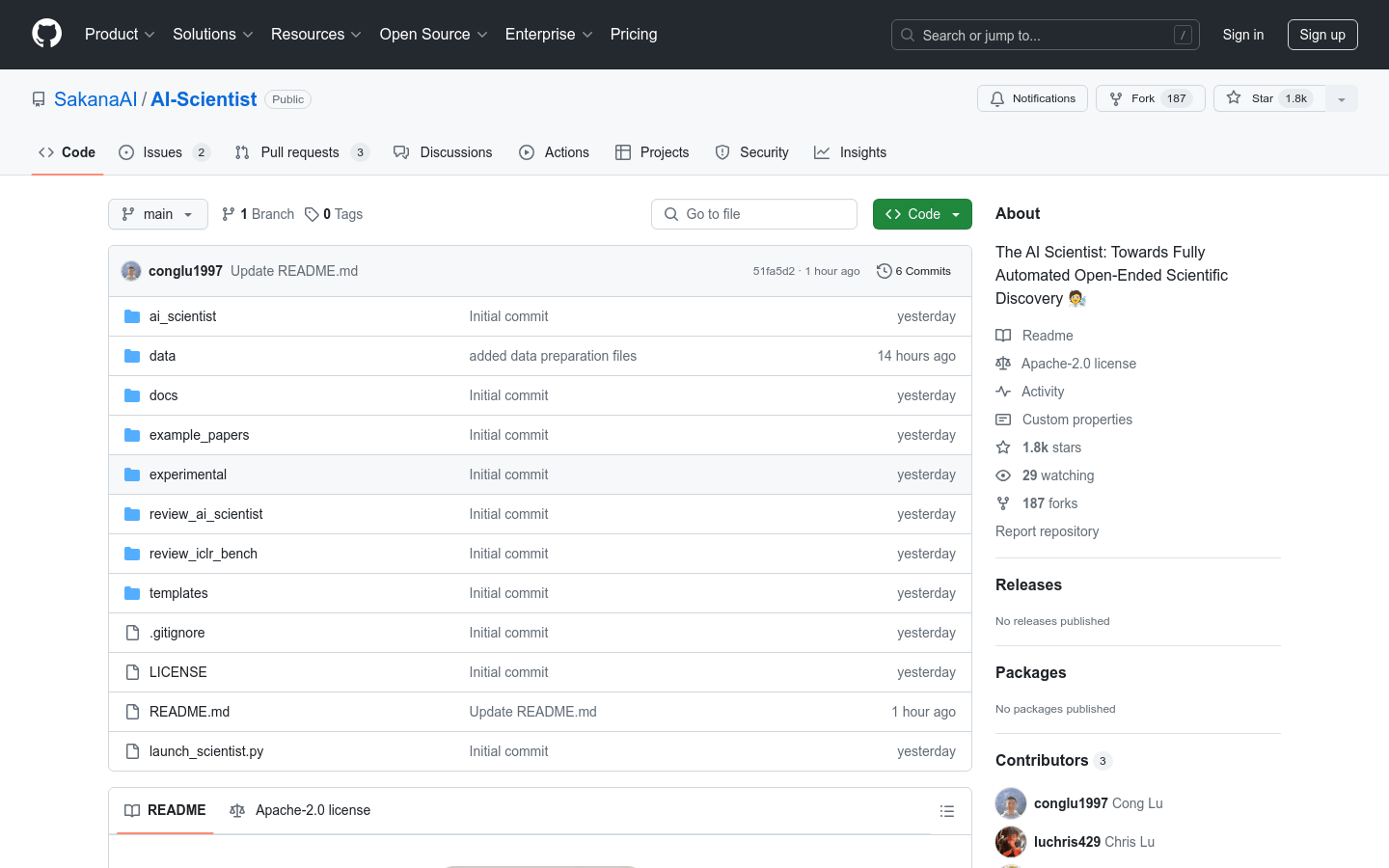

The AI ScientistThe AI Scientist 是一个全面的系统,旨在实现完全自动化的开放式科学发现。它使得基础模型,如大型语言模型(LLMs),能够独立进行研究。...

The AI ScientistThe AI Scientist 是一个全面的系统,旨在实现完全自动化的开放式科学发现。它使得基础模型,如大型语言模型(LLMs),能够独立进行研究。... -

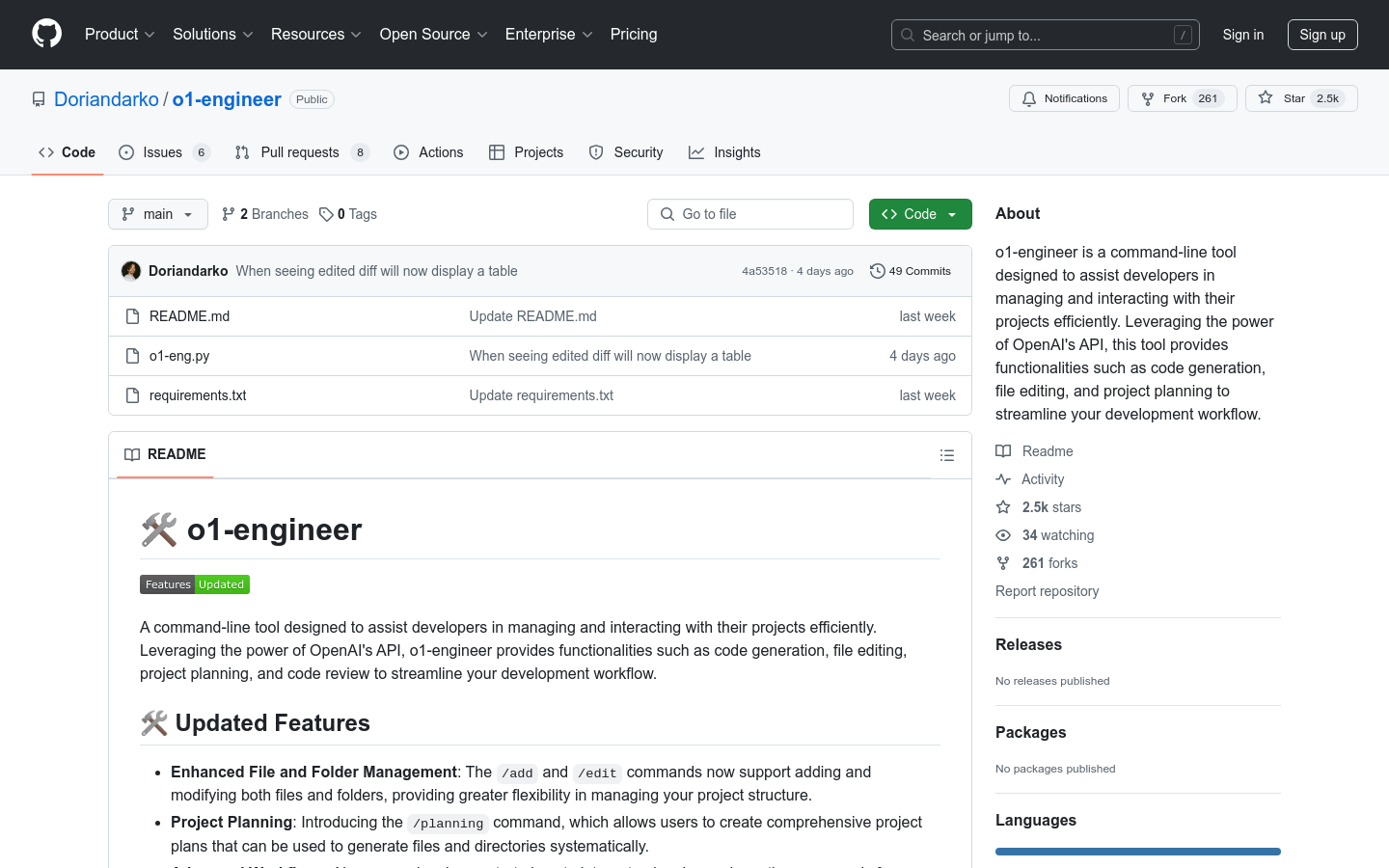

o1-engineero1-engineer 是一个命令行工具,旨在帮助开发者通过 OpenAI 的 API 高效地管理和交互项目。它提供了代码生成、文件编辑、项目规划等功...

o1-engineero1-engineer 是一个命令行工具,旨在帮助开发者通过 OpenAI 的 API 高效地管理和交互项目。它提供了代码生成、文件编辑、项目规划等功...

卓商AI

AI爱好者的一站式人工智能AI工具箱,累计收录全球10,000⁺好用的AI工具软件和网站,方便您更便捷的探索前沿的AI技术。本站持续更新好的AI应用,力争做全球排名前三的AI网址导航网站,欢迎您成为我们的一员。

最新收录

Spoke

Spoke是一款AI插件,为产品经理提供强大的、注重隐私的AI功能,能够在几秒钟内为用户提供上下文信息。它可以帮助全球快速增长的团队节省时间,创造上下...

LastMile AI

LastMile AI是一个AI开发平台,专为工程师而设计,可以用于原型开发和生成式AI应用的生产。它提供了一站式的多模态AI模型访问,包括语言模型(...

Dokkio

Dokkio是一款利用人工智能技术提供云文件协作的工具。它能帮助用户管理多个活动、搜索文档和文件、整理研究材料、组织内容库,并将所有文件和内容集中在一...

Engage Sphere AI

Engage Sphere是一个基于AI的员工参与度分析平台。它可以深入分析公司各个部门、团队和岗位的参与度,帮助管理者明确团队互动症结所在,并采取行...

Pikzels

Pikzels连接顶级人才和有远见的客户。我们促进协作,释放创意卓越。加入我们,获取来自各个领域的优秀专业人才。体验协作的力量,释放你的创意潜能。Pi...

Zoho Cliq

Zoho Cliq是一款专为提高企业工作效率而设计的在线即时通讯和协作平台。它将团队成员、对话和工作流集中在一个地方,实现无缝连接。主要功能包括:组织...

猜你喜欢

repeto ai

使用Repeto.ai(学生,研究人员和专业人士的AI平台)来增强您的学习。个性化的摘要,问答,测验和笔记提示优化您自己的文档的研究。现在使您的学习经...

Unify Plays

Unify Plays是一个商业营销平台,它通过集成AI、自动化和数据验证技术,帮助企业构建和运行能够生成潜在客户并促进销售的营销活动。这个平台的主要...

Export GPT - Export your chats with GPTs

这是一个可以将你与预训练模型GPT的聊天记录导出为可分享的PDF文件的插件。你可以使用它将聊天记录保存下来或与他人分享。...

Intuit Assist

Intuit Assist 是一款全球366科技平台,旨在通过 TurboTax、Credit Karma、QuickBooks 和 Mailchim...

GitHub Copilot

GitHub Copilot是一个由GitHub提供的AI驱动的代码补全工具,它通过机器学习技术帮助开发者在编写代码时提供智能的代码建议。该工具集成在...

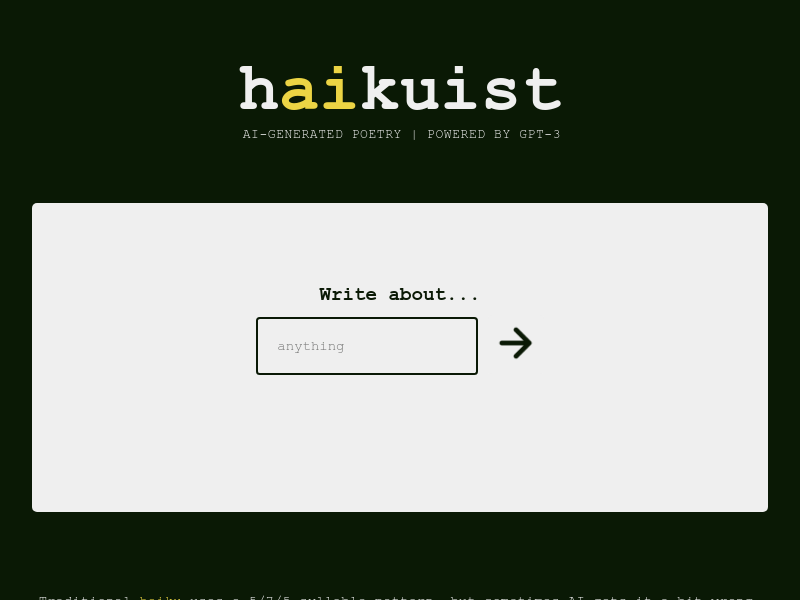

haikuist

Haikuist是一款由人工智能驱动的诗歌生成工具。它能够自动生成传统俳句风格的诗歌,帮助用户轻松创作美丽的诗句。Haikuist具有简单易用的界面,...

最新文章

1

2

3

4

5

6

7

8

9

10