上一个

gait相关AI工具集

-

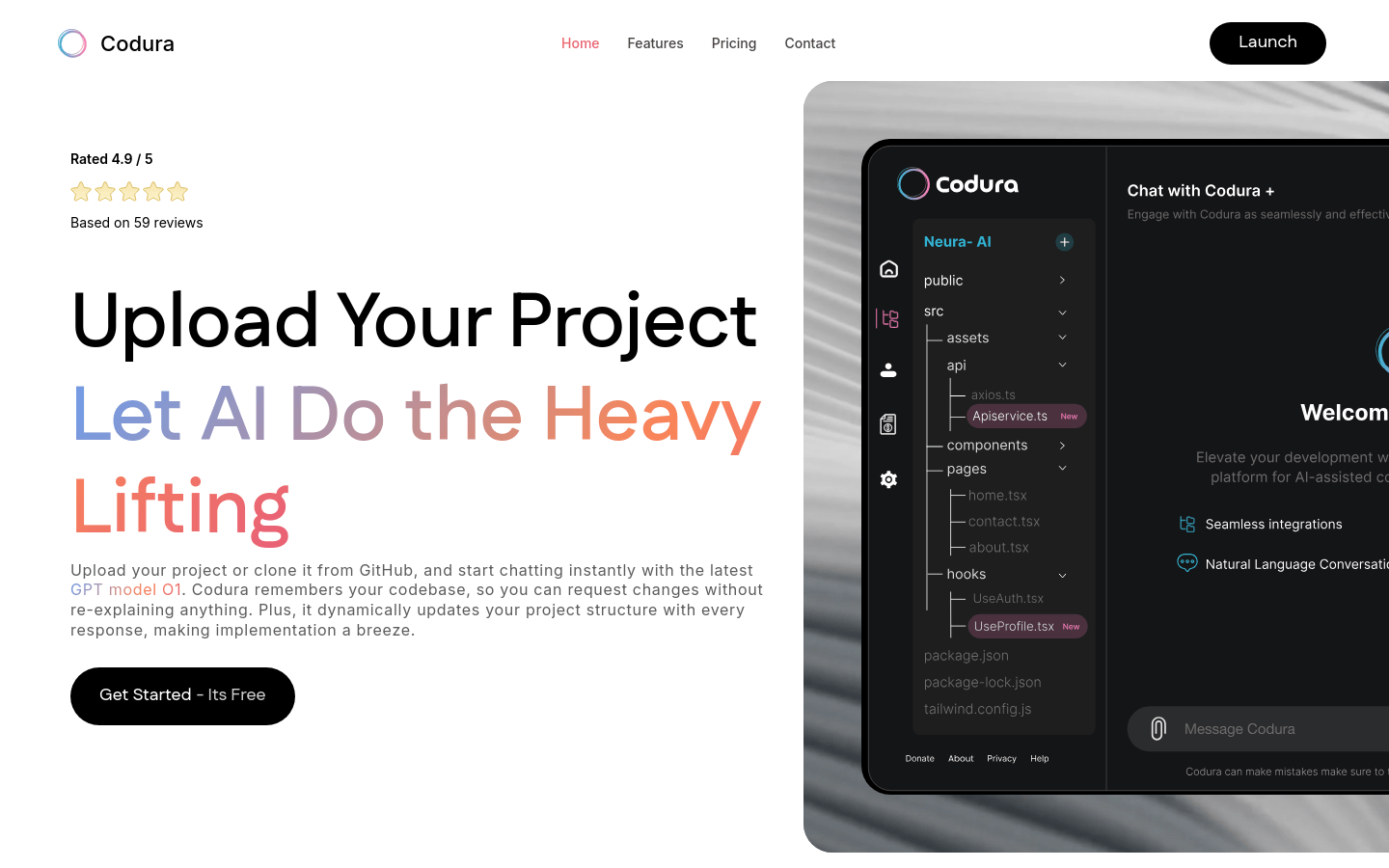

CoduraCodura是一个编程相关的网站,它可能提供了一些在线编程工具或服务。由于页面需要JavaScript支持,我们可以推测它可能包含了一些交互式功能,比...

CoduraCodura是一个编程相关的网站,它可能提供了一些在线编程工具或服务。由于页面需要JavaScript支持,我们可以推测它可能包含了一些交互式功能,比... -

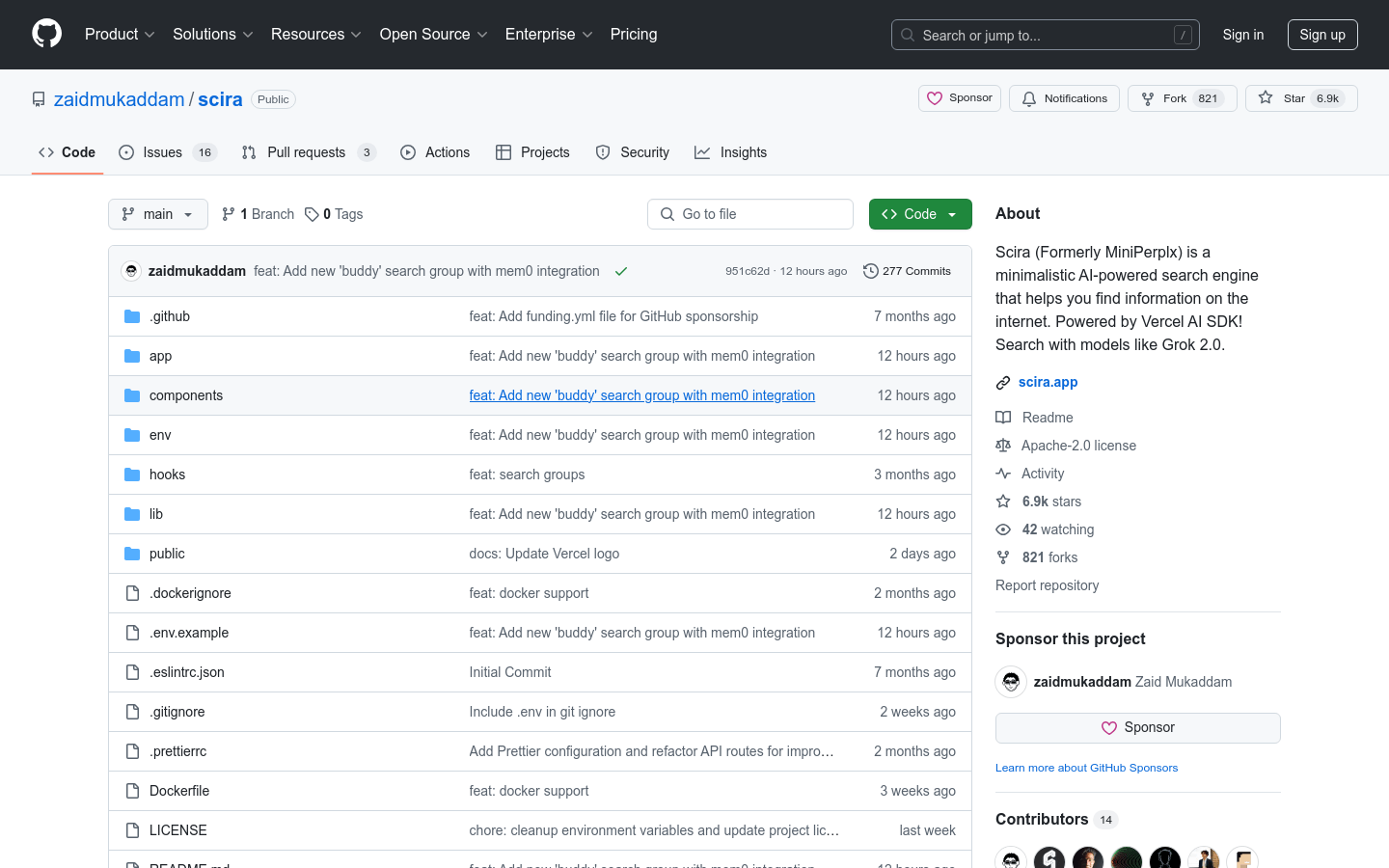

SciraScira 是一个基于 AI 技术的搜索引擎,旨在通过强大的语言模型和搜索能力,为用户提供更高效、更精准的信息检索体验。它支持多种语言模型,如 Gro...

SciraScira 是一个基于 AI 技术的搜索引擎,旨在通过强大的语言模型和搜索能力,为用户提供更高效、更精准的信息检索体验。它支持多种语言模型,如 Gro... -

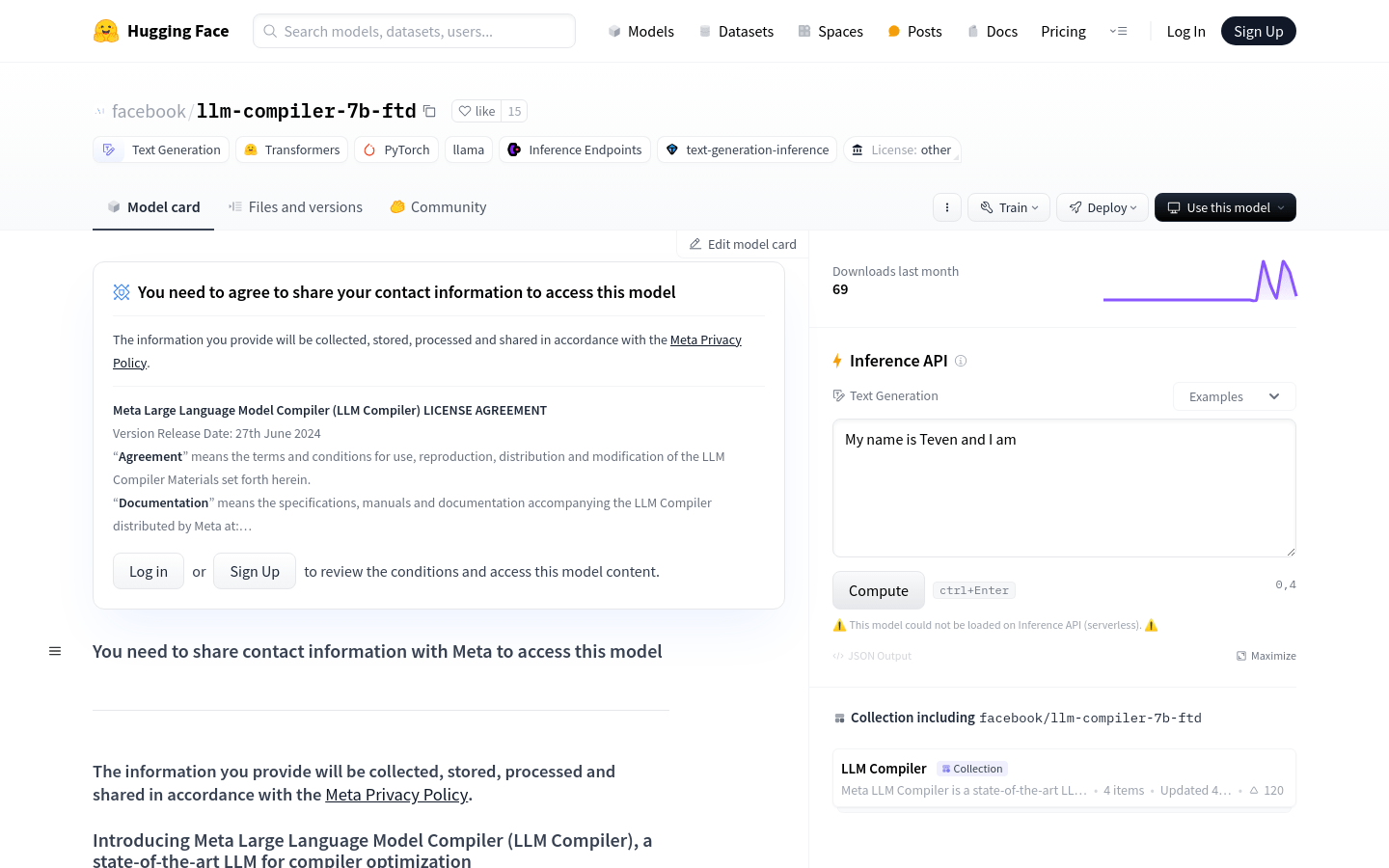

LLM Compiler-7b-ftdLLM Compiler-7b-ftd是由Meta开发的大型语言模型,它基于Code Llama,针对代码优化和编译器推理进行了改进。它在预测LLVM...

LLM Compiler-7b-ftdLLM Compiler-7b-ftd是由Meta开发的大型语言模型,它基于Code Llama,针对代码优化和编译器推理进行了改进。它在预测LLVM... -

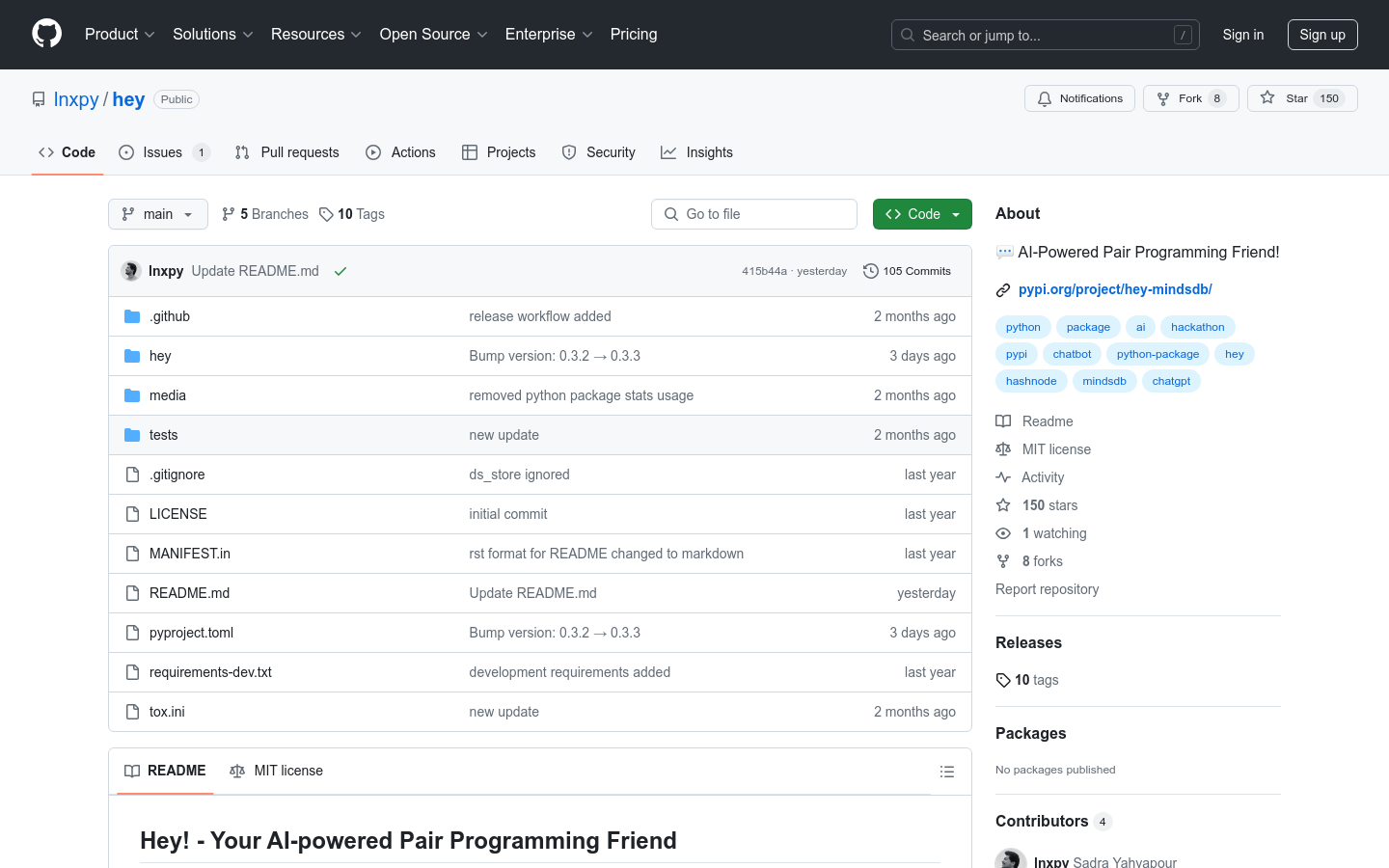

HeyHey是一个基于命令行界面的AI助手,由MindDB支持的ChatGPT AI模型版本驱动。该项目是为Hashnode X MindsDB黑客马拉松设...

HeyHey是一个基于命令行界面的AI助手,由MindDB支持的ChatGPT AI模型版本驱动。该项目是为Hashnode X MindsDB黑客马拉松设... -

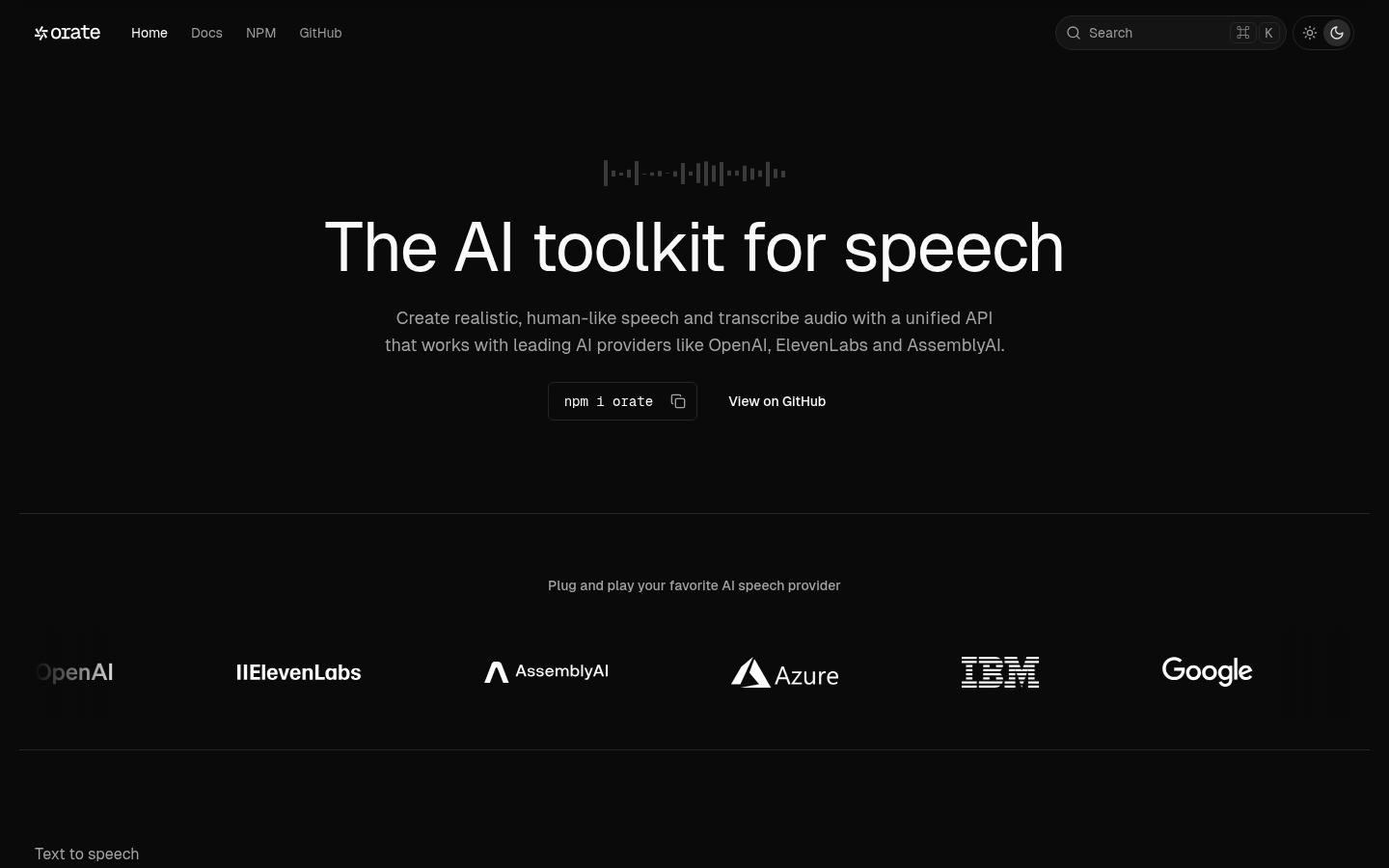

OrateOrate 是一个强大的 AI 语音工具包,能够将文本转换为逼真的语音,也可以将语音转换为文本,支持多种主流 AI 服务提供商。其主要优点是提供了一个...

OrateOrate 是一个强大的 AI 语音工具包,能够将文本转换为逼真的语音,也可以将语音转换为文本,支持多种主流 AI 服务提供商。其主要优点是提供了一个... -

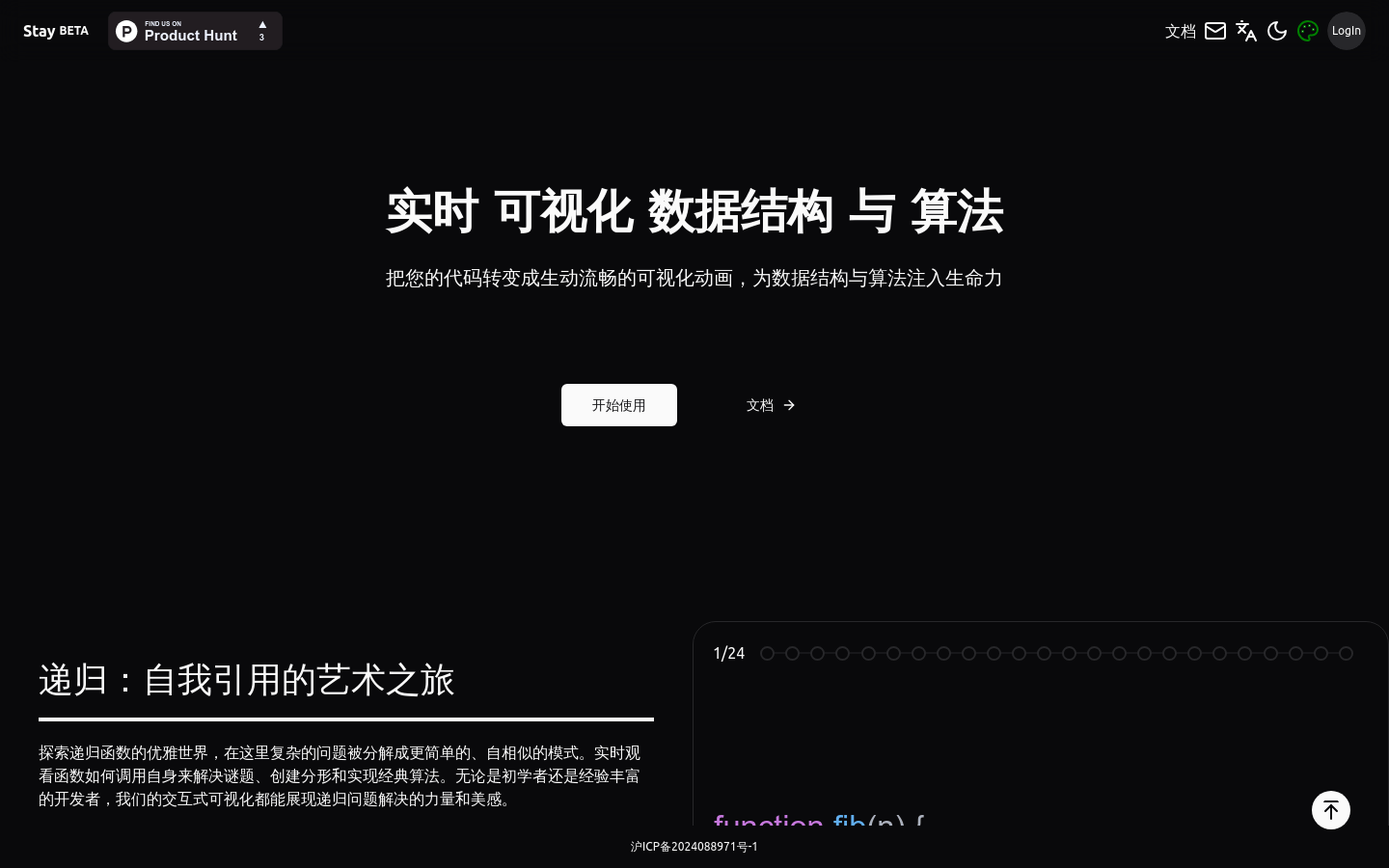

StayStay是一个专注于数据结构与算法可视化的编程学习网站。它通过将代码转化为生动流畅的动画,帮助学习者更直观地理解复杂的数据结构和算法原理。其主要优点在...

StayStay是一个专注于数据结构与算法可视化的编程学习网站。它通过将代码转化为生动流畅的动画,帮助学习者更直观地理解复杂的数据结构和算法原理。其主要优点在... -

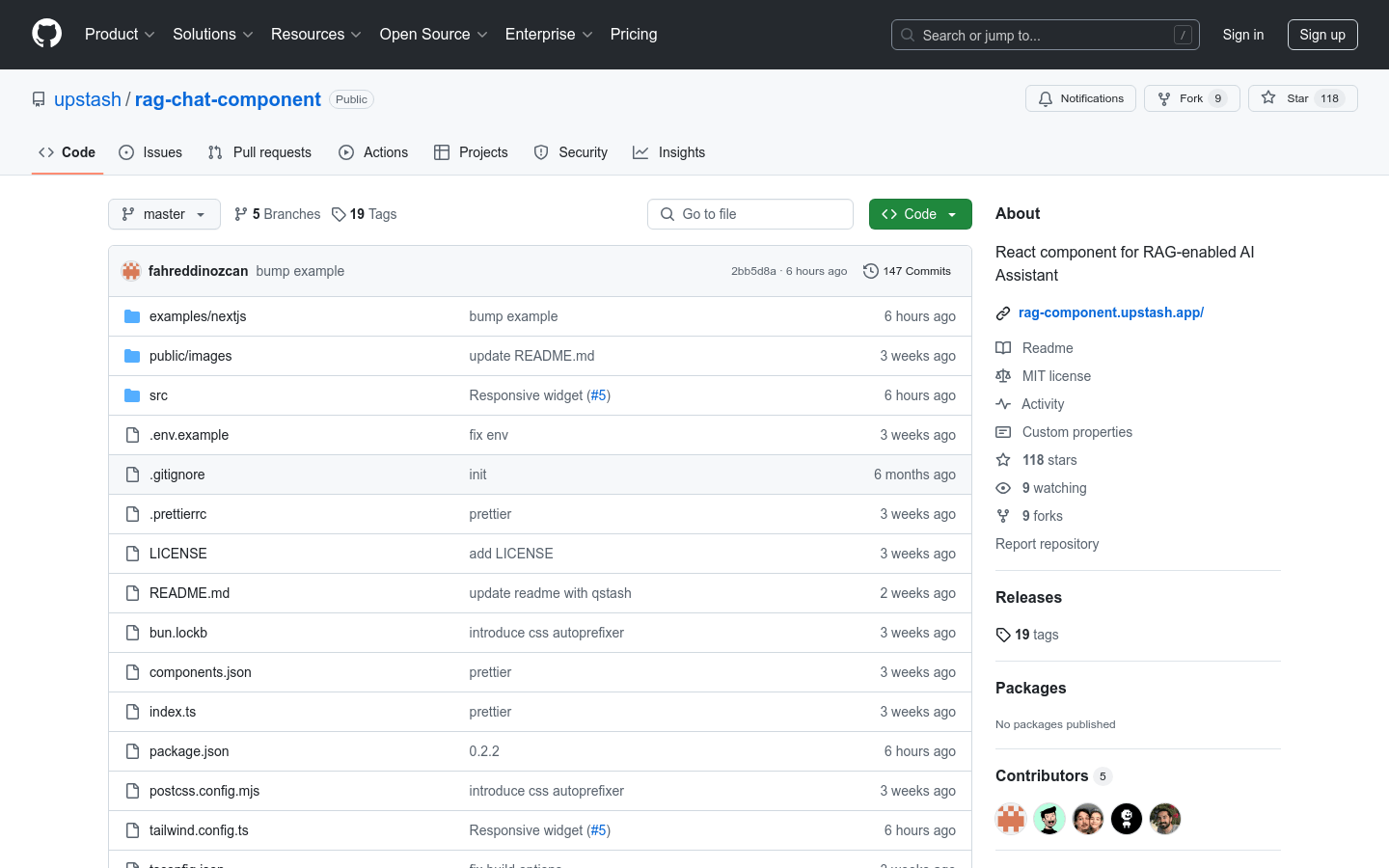

rag-chat-component该产品是一个React组件,专为RAG(检索增强生成)AI助手设计。它结合了Upstash Vector进行相似性搜索、Together AI作为LL...

rag-chat-component该产品是一个React组件,专为RAG(检索增强生成)AI助手设计。它结合了Upstash Vector进行相似性搜索、Together AI作为LL... -

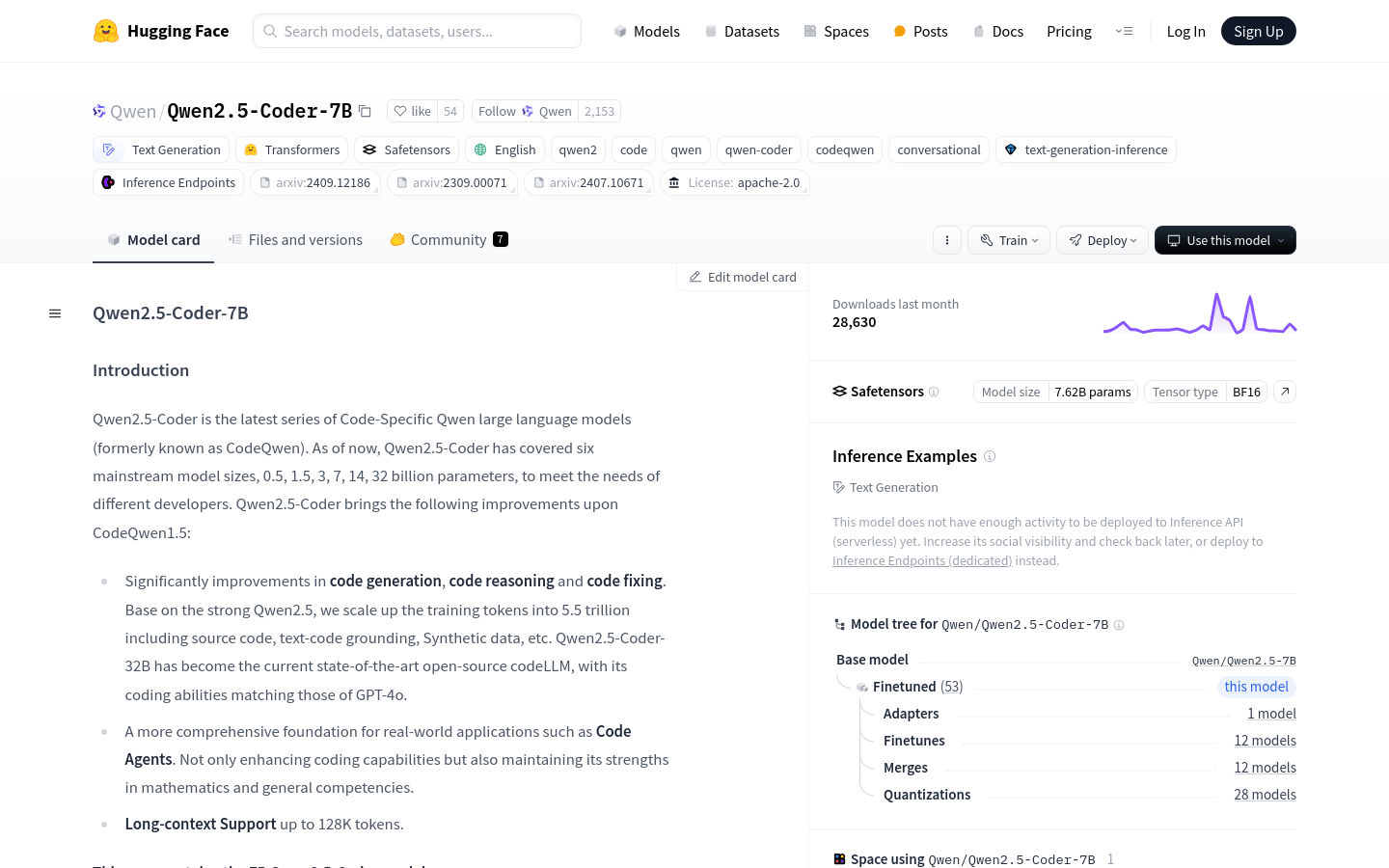

Qwen2.5-Coder-7BQwen2.5-Coder-7B是基于Qwen2.5的大型语言模型,专注于代码生成、代码推理和代码修复。它在5.5万亿的训练令牌上进行了扩展,包括源代...

Qwen2.5-Coder-7BQwen2.5-Coder-7B是基于Qwen2.5的大型语言模型,专注于代码生成、代码推理和代码修复。它在5.5万亿的训练令牌上进行了扩展,包括源代... -

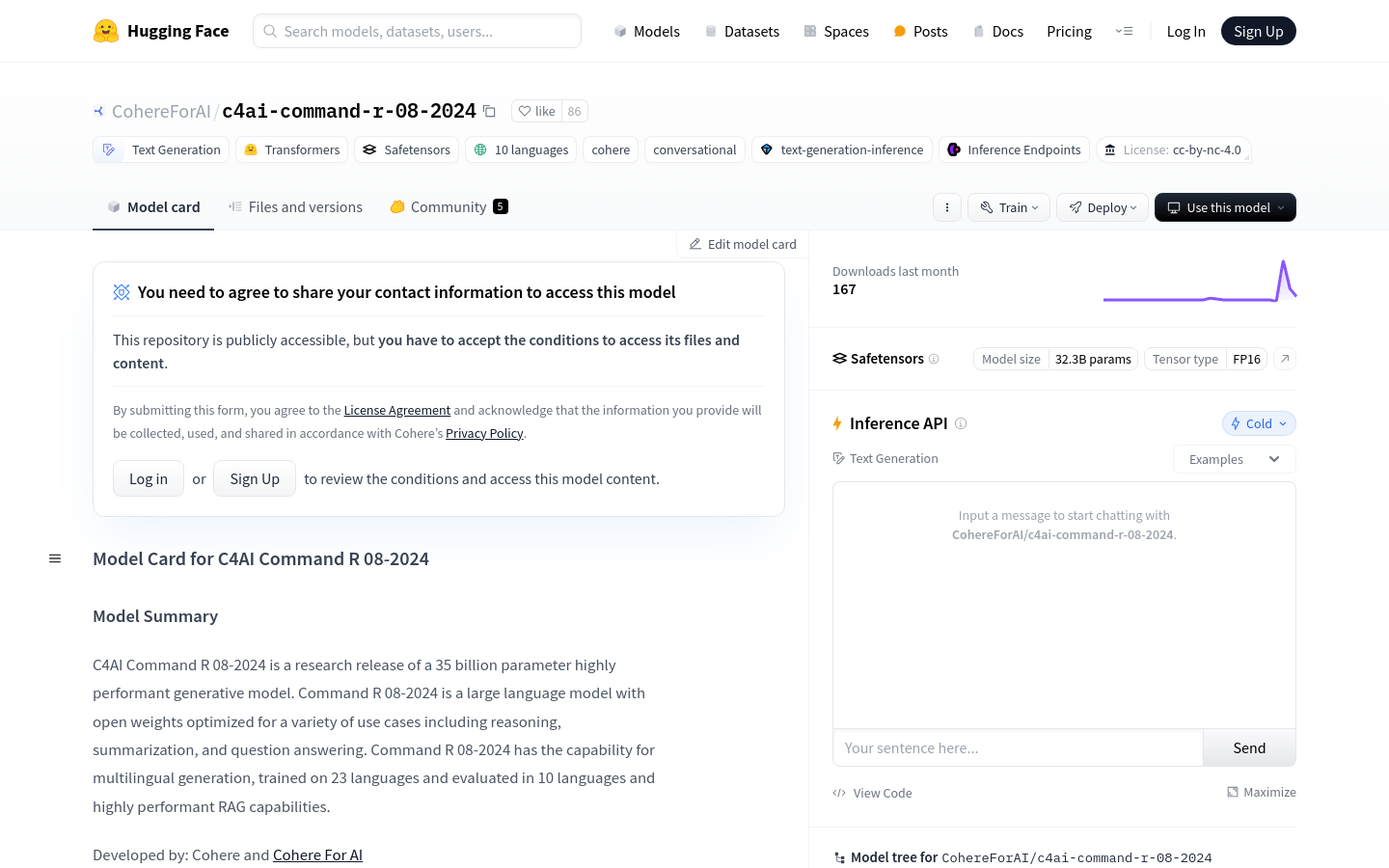

C4AI CommandR 08-2024C4AI Command R 08-2024是由Cohere和Cohere For AI开发的35亿参数大型语言模型,专为推理、总结和问答等多种用例优...

C4AI CommandR 08-2024C4AI Command R 08-2024是由Cohere和Cohere For AI开发的35亿参数大型语言模型,专为推理、总结和问答等多种用例优... -

Fenado AIFenado AI是一款强大的生产力工具,它通过人工智能技术,让用户能够快速地将想法转化为实际的应用程序和网站。其主要优点是能够大大缩短开发周期,降低...

Fenado AIFenado AI是一款强大的生产力工具,它通过人工智能技术,让用户能够快速地将想法转化为实际的应用程序和网站。其主要优点是能够大大缩短开发周期,降低... -

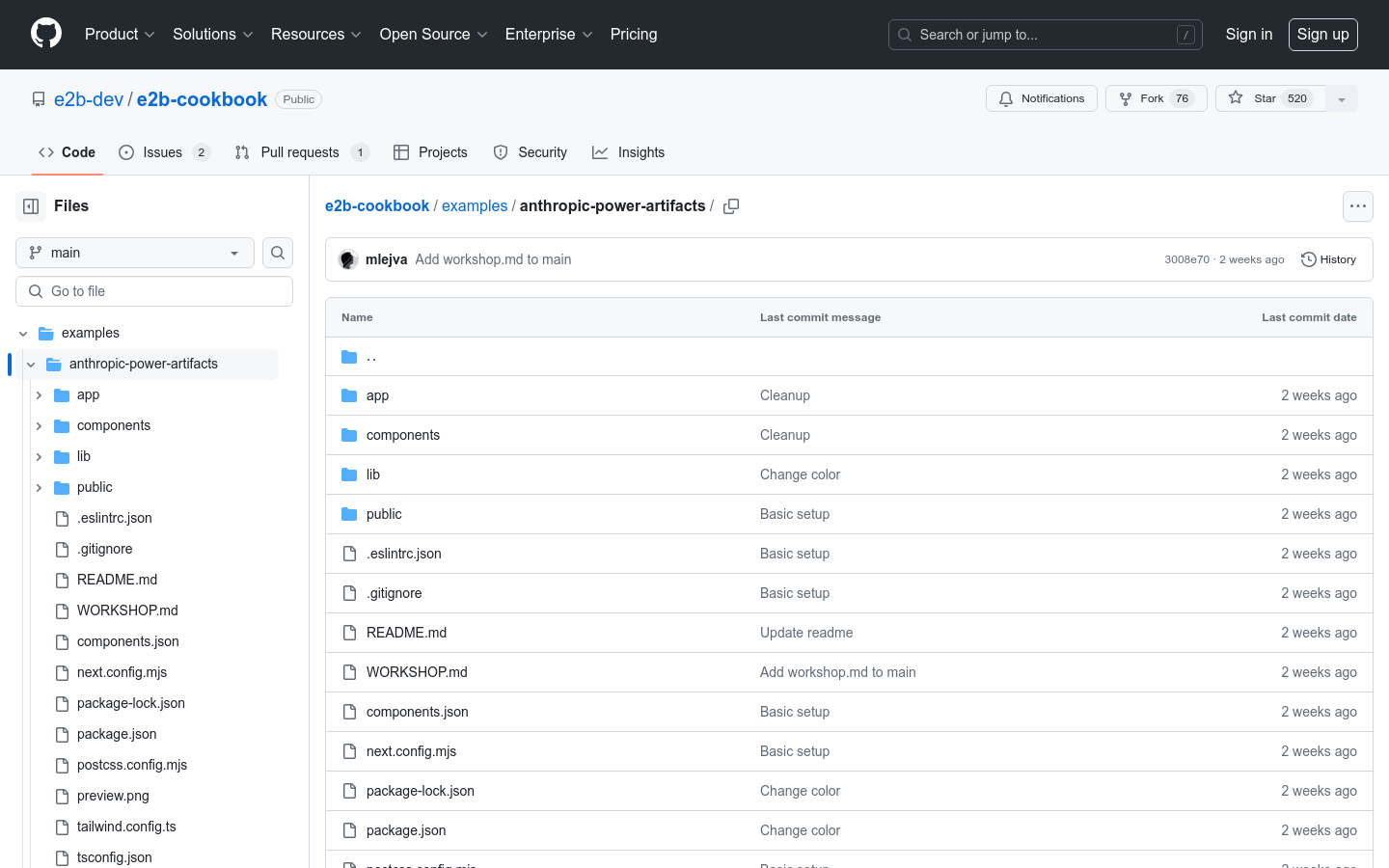

Anthropic Power ArtifactsAnthropic Power Artifacts是一个开源项目,它复现了Anthropic公司在其Claude聊天应用中的Artifacts用户界面...

Anthropic Power ArtifactsAnthropic Power Artifacts是一个开源项目,它复现了Anthropic公司在其Claude聊天应用中的Artifacts用户界面... -

DEV ChallengesDEV Challenges是一个类似于小型黑客马拉松的活动,为开发者提供了一个展示技能、积累经验、与社区互动的平台。参与者可以通过解决实际问题来提升...

DEV ChallengesDEV Challenges是一个类似于小型黑客马拉松的活动,为开发者提供了一个展示技能、积累经验、与社区互动的平台。参与者可以通过解决实际问题来提升...

卓商AI

AI爱好者的一站式人工智能AI工具箱,累计收录全球10,000⁺好用的AI工具软件和网站,方便您更便捷的探索前沿的AI技术。本站持续更新好的AI应用,力争做全球排名前三的AI网址导航网站,欢迎您成为我们的一员。

最新收录

Spoke

Spoke是一款AI插件,为产品经理提供强大的、注重隐私的AI功能,能够在几秒钟内为用户提供上下文信息。它可以帮助全球快速增长的团队节省时间,创造上下...

LastMile AI

LastMile AI是一个AI开发平台,专为工程师而设计,可以用于原型开发和生成式AI应用的生产。它提供了一站式的多模态AI模型访问,包括语言模型(...

Dokkio

Dokkio是一款利用人工智能技术提供云文件协作的工具。它能帮助用户管理多个活动、搜索文档和文件、整理研究材料、组织内容库,并将所有文件和内容集中在一...

Engage Sphere AI

Engage Sphere是一个基于AI的员工参与度分析平台。它可以深入分析公司各个部门、团队和岗位的参与度,帮助管理者明确团队互动症结所在,并采取行...

Pikzels

Pikzels连接顶级人才和有远见的客户。我们促进协作,释放创意卓越。加入我们,获取来自各个领域的优秀专业人才。体验协作的力量,释放你的创意潜能。Pi...

Zoho Cliq

Zoho Cliq是一款专为提高企业工作效率而设计的在线即时通讯和协作平台。它将团队成员、对话和工作流集中在一个地方,实现无缝连接。主要功能包括:组织...

猜你喜欢

freshservice

FreshService是一个全面的IT服务管理平台,旨在帮助企业充分利用其IT投资。它提供了一种无缝的方式来优化投资和简化工作流程,使团队能够为用户...

adsby keyword generator

毫不费力地生成关键字!只需输入您的信息,然后让Adsby为您的Google广告,博客和所有其他SEO内容生成完美的关键字。...

domyshoot

DomyShoot在您的智能手机上提供工作室优质的产品摄影。该应用程序提供指导的产品摄影,并提供按需照片编辑,并自动化自动化的营销内容。如果您可以拍摄...

Sticker Prompt Generator

AI艺术贴纸生成器是一款能够一键生成10个独特的艺术AI风格贴纸的工具。用户不需要花费大量时间去寻找适合的风格,只需点击一次即可生成10种独特的组合风...

Codestral-22B-v0.1

Codestral-22B-v0.1是由Mistral AI Team开发的大型语言模型,它经过了80多种编程语言的训练,包括Python、Java、...

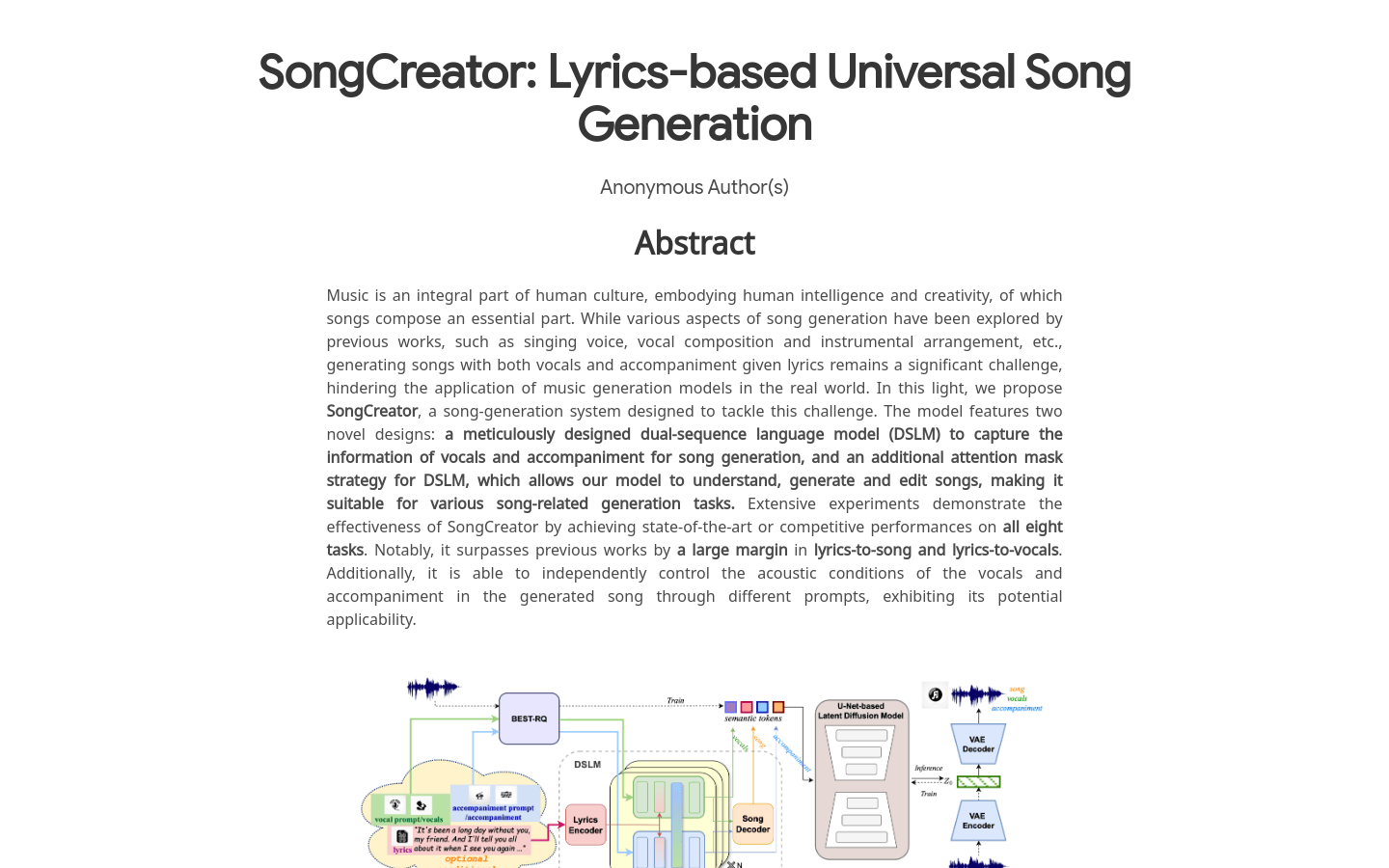

SongCreator

SongCreator是一个基于人工智能技术的歌词生成歌曲工具,它能够将文本歌词转化为完整的音乐作品。这一技术的应用不仅为音乐创作者提供了便捷的创作途...

最新文章

1

2

3

4

5

6

7

8

9

10