下一个

Llama Coder

相关AI工具集

-

LovableLovable是一个创新的全栈工程平台,它允许用户通过自然语言描述自己的想法,快速将概念转化为功能完备的应用程序。这个平台以其超快速的开发流程、直观的...

LovableLovable是一个创新的全栈工程平台,它允许用户通过自然语言描述自己的想法,快速将概念转化为功能完备的应用程序。这个平台以其超快速的开发流程、直观的... -

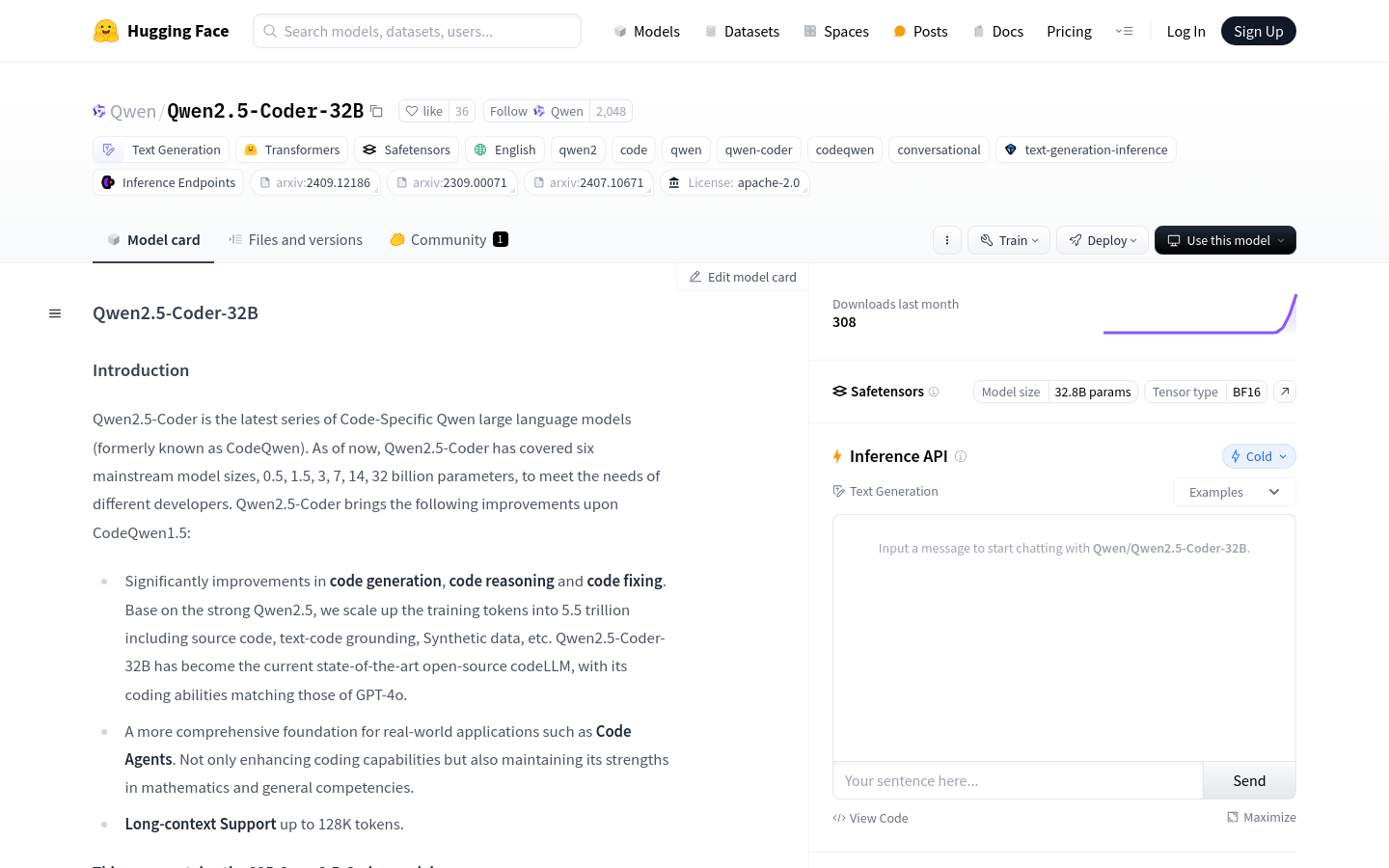

Qwen2.5-Coder-32BQwen2.5-Coder-32B是基于Qwen2.5的代码生成模型,拥有32亿参数,是目前开源代码语言模型中参数最多的模型之一。它在代码生成、代码推...

Qwen2.5-Coder-32BQwen2.5-Coder-32B是基于Qwen2.5的代码生成模型,拥有32亿参数,是目前开源代码语言模型中参数最多的模型之一。它在代码生成、代码推... -

edCodeedCode是一个面向所有人,从初学者到专家的编程学习平台。它提供AI面试准备功能,帮助用户学习编程或为梦想工作做准备。平台强调学习的乐趣,提供自定进...

edCodeedCode是一个面向所有人,从初学者到专家的编程学习平台。它提供AI面试准备功能,帮助用户学习编程或为梦想工作做准备。平台强调学习的乐趣,提供自定进... -

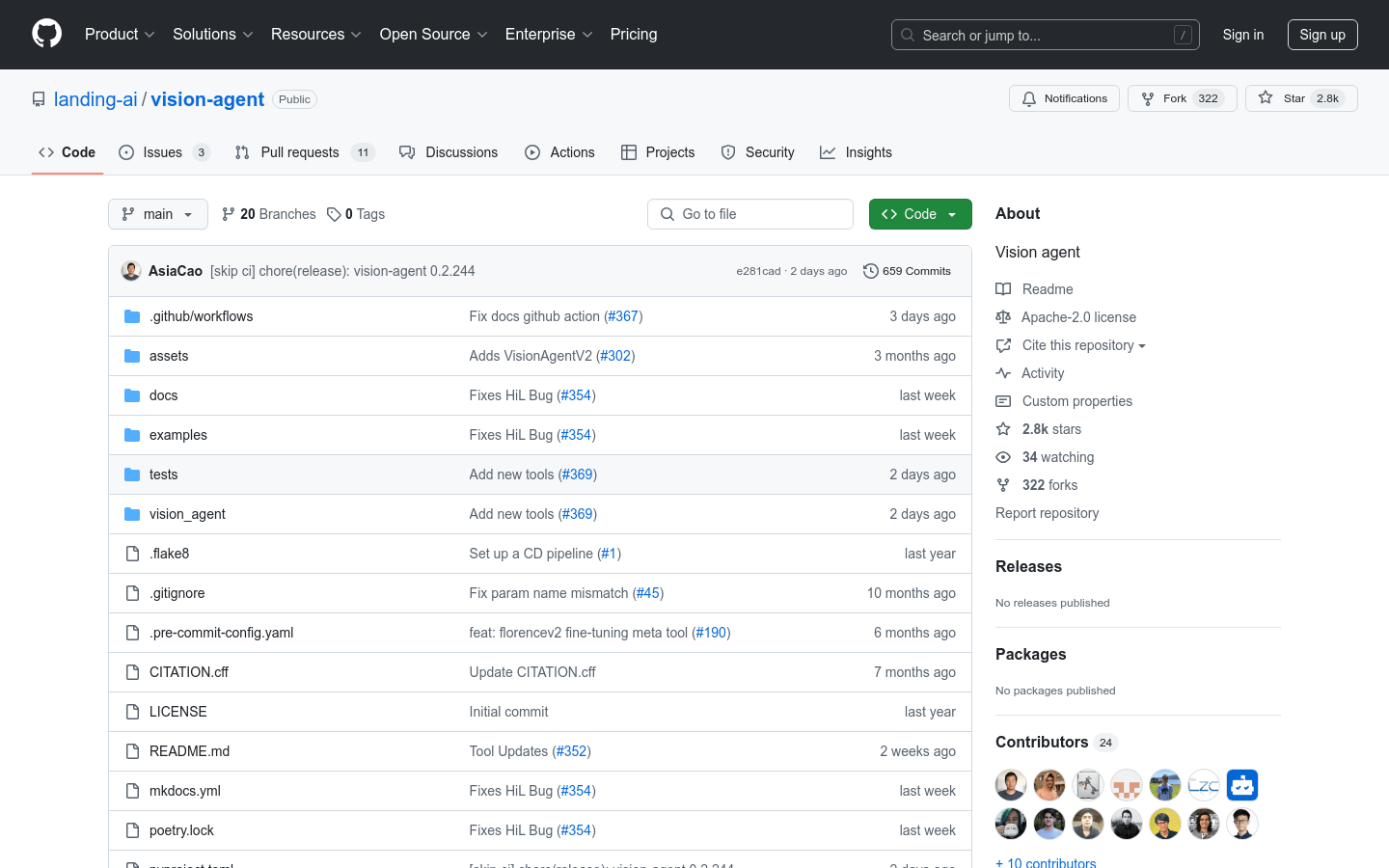

VisionAgentVisionAgent是一个强大的工具,它利用人工智能和大语言模型(LLM)来生成代码,帮助用户快速解决视觉任务。该工具的主要优点是能够自动将复杂的视...

VisionAgentVisionAgent是一个强大的工具,它利用人工智能和大语言模型(LLM)来生成代码,帮助用户快速解决视觉任务。该工具的主要优点是能够自动将复杂的视... -

Gemini 2.5Gemini 2.5 是谷歌推出的最先进的 AI 模型,具备高效的推理能力和编码性能,能够处理复杂问题,并在多项基准测试中表现出色。该模型引入了新的思...

Gemini 2.5Gemini 2.5 是谷歌推出的最先进的 AI 模型,具备高效的推理能力和编码性能,能够处理复杂问题,并在多项基准测试中表现出色。该模型引入了新的思... -

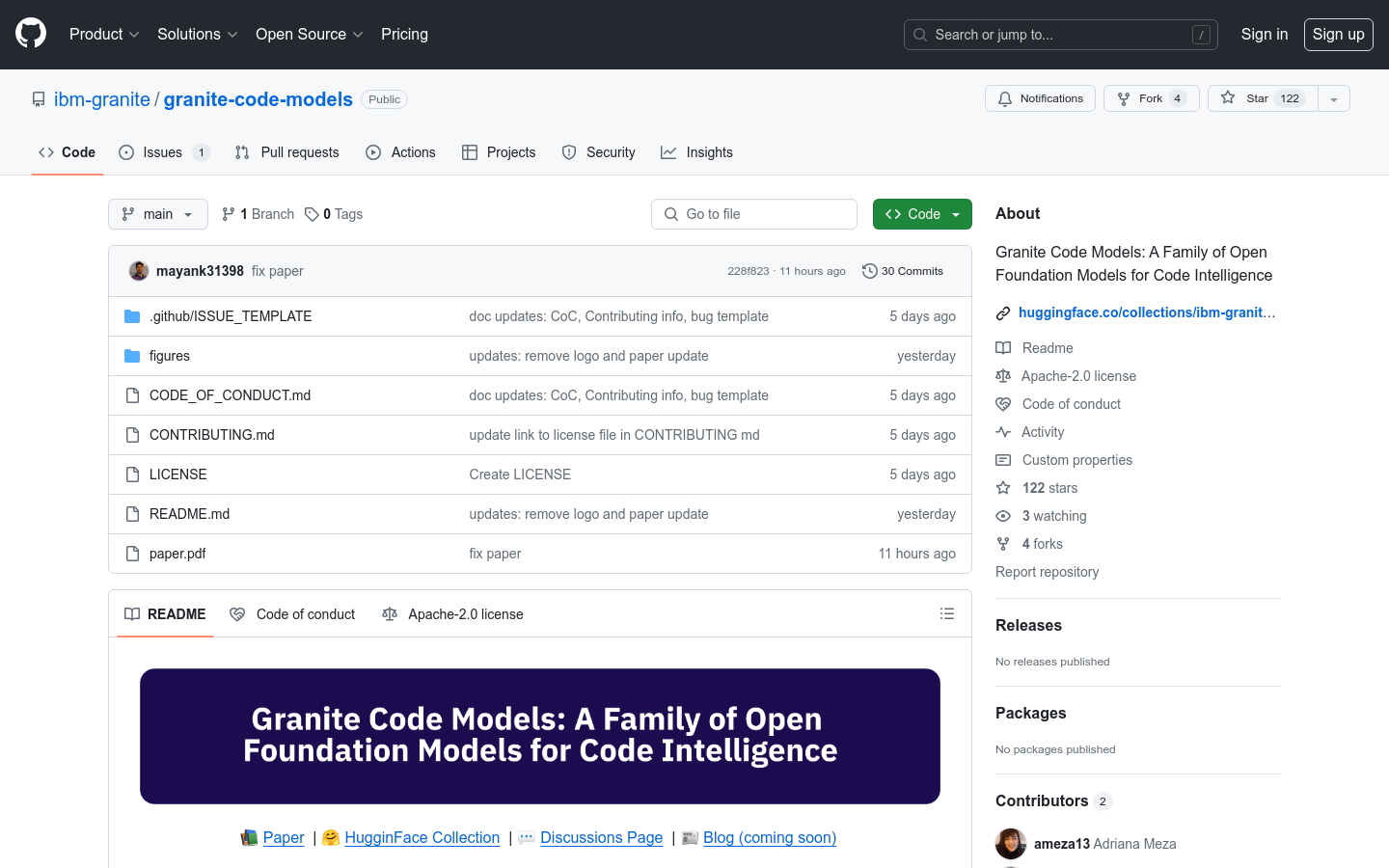

Granite Code ModelsGranite Code Models 是 IBM 开发的一系列开源基础模型,专为代码生成任务设计,如修复错误、解释代码、文档化代码等。这些模型在多种...

Granite Code ModelsGranite Code Models 是 IBM 开发的一系列开源基础模型,专为代码生成任务设计,如修复错误、解释代码、文档化代码等。这些模型在多种... -

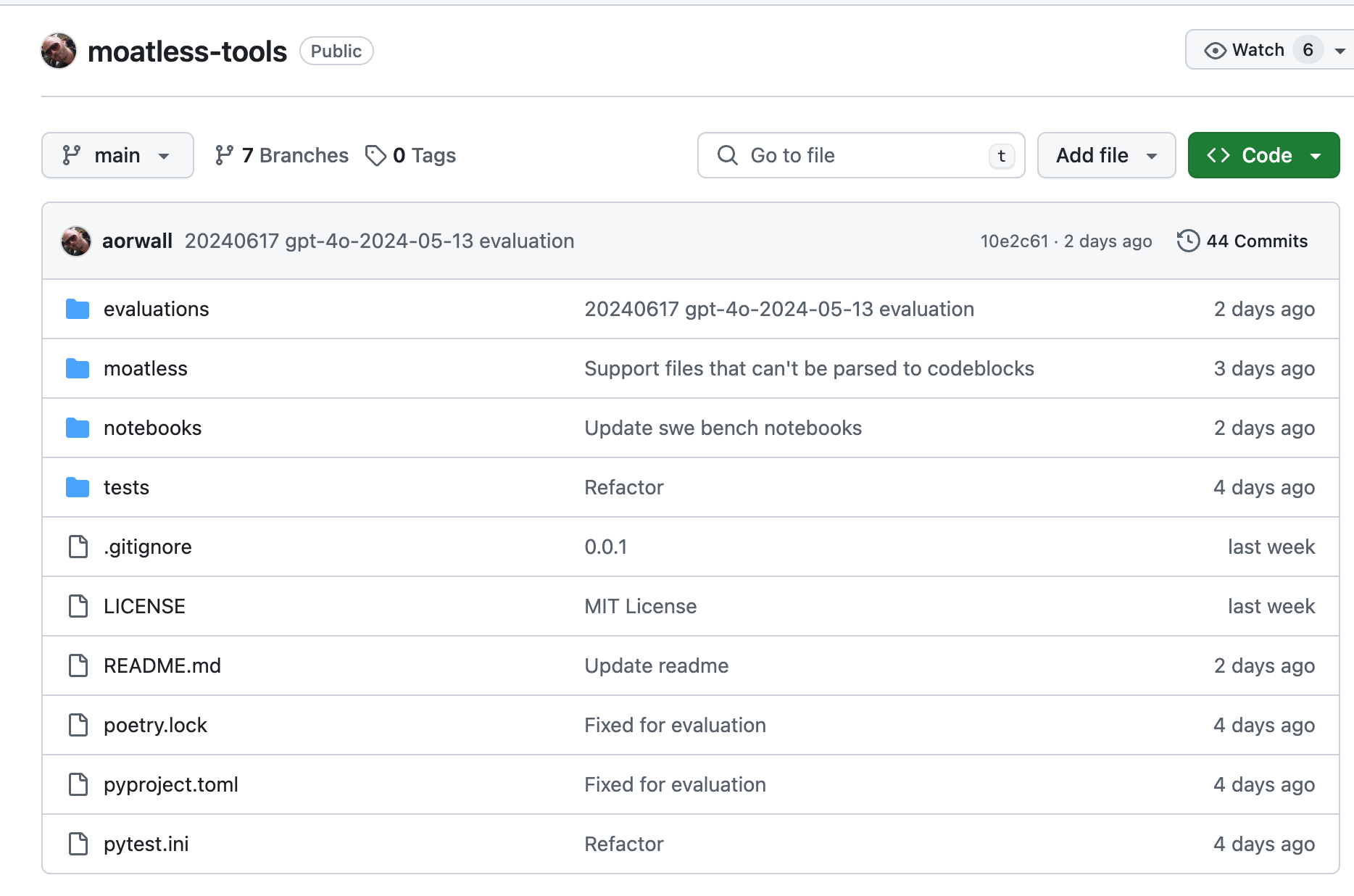

Moatless ToolsMoatless Tools 是一个业余项目,作者在这里尝试一些关于如何使用大型语言模型(LLMs)来编辑大型现有代码库的想法。项目认为,构建好工具以...

Moatless ToolsMoatless Tools 是一个业余项目,作者在这里尝试一些关于如何使用大型语言模型(LLMs)来编辑大型现有代码库的想法。项目认为,构建好工具以... -

ZeroPathZeroPath是一个自动化安全工具,旨在帮助开发者通过集成现有的静态应用程序安全测试(SAST)工具,自动验证和修复代码中的安全漏洞。它通过减少约9...

ZeroPathZeroPath是一个自动化安全工具,旨在帮助开发者通过集成现有的静态应用程序安全测试(SAST)工具,自动验证和修复代码中的安全漏洞。它通过减少约9... -

Windsurf Wave 2Windsurf Wave 2 是 Codeium 团队推出的一款面向开发者的编程辅助工具的第二波更新。它通过 AI 技术为开发者提供智能代码生成、代...

Windsurf Wave 2Windsurf Wave 2 是 Codeium 团队推出的一款面向开发者的编程辅助工具的第二波更新。它通过 AI 技术为开发者提供智能代码生成、代... -

VBA Code GeneratorVBA Code Generator是一个利用人工智能技术,帮助用户快速生成VBA代码的在线工具。它为Excel自动化和Access数据库管理等提供了...

VBA Code GeneratorVBA Code Generator是一个利用人工智能技术,帮助用户快速生成VBA代码的在线工具。它为Excel自动化和Access数据库管理等提供了... -

ZionZion是一个无代码开发平台,它通过提供预置的大模型和完善的生态服务体系,使得用户无需编写代码即可构建AI应用、SaaS应用和消费级应用。该平台支持高...

ZionZion是一个无代码开发平台,它通过提供预置的大模型和完善的生态服务体系,使得用户无需编写代码即可构建AI应用、SaaS应用和消费级应用。该平台支持高... -

GitHub to LLM ConverterGitHub to LLM Converter是一个在线工具,旨在帮助用户将GitHub上的项目、文件或文件夹链接转换成适合大型语言模型(LLM)处理...

GitHub to LLM ConverterGitHub to LLM Converter是一个在线工具,旨在帮助用户将GitHub上的项目、文件或文件夹链接转换成适合大型语言模型(LLM)处理...

卓商AI

AI爱好者的一站式人工智能AI工具箱,累计收录全球10,000⁺好用的AI工具软件和网站,方便您更便捷的探索前沿的AI技术。本站持续更新好的AI应用,力争做全球排名前三的AI网址导航网站,欢迎您成为我们的一员。

最新收录

VoteGPT

VoteGPT是一个选举辅助网站,它通过官方政策和维基百科提供的信息,帮助用户了解不同候选人和政党的立场。该产品的主要优点是提供简单、诚实、无偏见的信...

Roughly

Roughly是一款基于Web的绘画工具,旨在帮助用户以自由、简单和有趣的方式创作数字艺术。它提供了各种绘画工具和画布,以及许多功能,如图层、颜色选择...

niji journey

niji・journey是一款AI艺术生成器,通过输入文字或上传图片,生成令人惊叹的动漫画。它拥有世界上最先进的AI艺术模型,可以生成可爱、富有表现力...

Mentor AI

Mentor AI是一款功能强大且直观的工具,利用先进的人工智能技术帮助您快速高效地完成任务。您可以向Mentor AI询问各种问题,包括撰写和校对论...

furryfriends.ai

furryfriends.ai是一款可以生成宠物肖像画的AI产品。用户只需上传宠物照片,选择喜欢的艺术风格,即可生成多张宠物肖像画。该产品提供三种套餐...

MacBook Pro

全新MacBook Pro是苹果公司推出的高性能笔记本电脑,它搭载了苹果自家设计的M4系列芯片,包括M4、M4 Pro和M4 Max,提供了更快的处理...

猜你喜欢

the multiverse ai

Multiverse AI提供工作室质量的专业头像,以提升您的在线形象。上传您的自拍照,并在几个小时内以各种样式收到100个专业头像。无需应用程序或注...

aisong

使用Aisong创建自己的音乐 - 免费的AI歌曲和歌词生成器! Aisong Innovative Platform使用尖端的AI技术来通过歌词和乐...

Qlik AutoML

Qlik AutoML是一款为分析团队提供无代码、自动化机器学习的工具。它能够快速生成模型、进行预测和决策规划。用户可以轻松创建机器学习实验,识别数据...

vocalo ai

通过Vocalo.ai(AI驱动的平台)提高您的英语技能,该平台在说话,听力,语法等方面立即提供帮助。非常适合寻求全面有效的实践经验的语言学习者。...

careerspark

CareerSpark是一个AI驱动的内容生成平台,旨在简化早期职业专业人员和学生的求职和研究过程。该平台提供及时,准确的内容,以帮助用户掌握研究和求...

Beeyond AI

Beeyond AI 是一款一体化的网络应用程序,为用户提供智能、个性化的帮助,节省时间并提高生产力。它包括 AI 编辑器、音频笔记、艺术工作室、与 ...

最新文章

1

2

3

4

5

6

7

8

9

10